История о том, как простой парень из депрессивного региона России пытается заявить о себе — и о том, что стереотипы говно.

Привет. Меня зовут Даниял Деветов, я iOS-разработчик в компании FINCH. Пока я еще junior, но крепкий, я бы даже сказал «почти middle».

Родом я из города Махачкала, столицы солнечного и очень любимого мной Дагестана. Да, того самого Дагестана, откуда, по мнению многих наших соотечественников, родом только спортсмены и ребята, которые приезжают в Москву «порядок наводить». Это, конечно, мешает карьерному развитию — стереотипы такие стереотипы! Хотя, на самом деле, Дагестан вырастил много успешных людей в IT — вроде Тагира Магомедова из Uber и Камиля Насруллаева из Mail.ru.

Мой путь в IT начался в 18 лет. Сейчас мне почти 20, и у меня есть бэкграунд в 1,5 года беспрерывного продакшн опыта. С того момента, как я стал программистом, очень часто поступают вопросы от земляков: «Вау, как круто, сидеть весь день за компом и зарабатывать кучу бабла — как бы и мне так сделать?». Там, откуда я родом, люди часто не верят, что можно пробиться в такую престижную профессию и работать в теплом офисе за хорошие деньги.

В этой статье я расскажу, как от оператора 1С на пивном складе я дорос до iOS-программиста в крупной московской компании. Надеюсь, что мой пример вдохновит кого-то еще из депрессивных регионов развиваться и не сдаваться!

Место, где ничему не учат

Мой карьерный путь начался с того, что я СОИЗВОЛИЛ прийти на пары в свой колледж. На самом деле, учиться я особо не планировал, и уж тем более получать высшее образование. Еще в 13 лет я подумал: «нафига мне универ, до которого еще учиться и учиться? Надо быстрее бабки зарабатывать!». Так что даже особо не думал, куда отдавать документы после окончания 9 классов.

Я поступил в бизнес-колледж при Государственном Дагестанском Университете Народного Хозяйства. Откуда там появился факультет программирования — не знаю. Вообще, колледж славился тем, что туда мог попасть любой. На поток в 700 человек набиралось 1200, и на первом курсе отсеивали человек 300 самых «отбитых» студентов.

Снаружи колледж выглядит как-то так

На факультет программирования обычно поступали те, кто после окончания школы не знал, чего хочет от этой жизни. При этом родители говорили им, что нужно поступить в вуз и получить диплом, хорошую профессию и так далее. При поступлении они видят программирование, думают «Это сейчас модно, ну и я вроде умею работать с компом» — и подают документы. Поэтому, если в потоке на факультете 1000 человек, то в лучшем случае около 50 вообще понимают, что же такое программирование. И при удачном стечении обстоятельств 10-15 из них могут куда-то пробиться. Представьте, каковы были мои шансы!

Самое обучение выглядит так. На первых двух курсах ничего профильного нет. На третьем курсе начинается программирование — приходит препод и начинает читать лекции про Pascal ABC. Во втором семестре третьего курса появляется препод, который рассказывает, что такое C#. На четвертом курсе материал повторяется.

Мне повезло — один крутой преподаватель, Гасан Гусейнович, заметил, что я быстро схватываю материал. Спасибо моему старшему брату — еще в 12 лет он показал мне, что такое программирование. Я ходил к нему по вечерам, когда он приходил с учебы, чтобы познавать азы Delphi и Pascal. Тот же брат подарил мне комплектующие для компьютера — я собрал его самостоятельно и стал изучать на нем Delphi 7.

Так вот, однажды в личном разговоре со мной Гасан Гусейнович настоял, чтобы я пошел на курсы компании DIIT Center. Курсы были хороши тем, что лучший студент по окончании учебы направлялся на стажировку в компанию. Для DIIT брать зеленых выпускников технических вузов и колледжей — это единственный вариант найти каких-то специалистов, так как с IT-специалистами в Дагестане все очень плохо.

Все мои знакомые, за исключением единиц, просто поржали. Они говорили что-то вроде: «да какие курсы, дурачок, деньги на ветер выкинул, лучше бы стол накрыл, если бабло девать некуда!». Но это мне не помешало все-таки пойти туда и попробовать. Дальше дело оставалось за малым — обойти всех студентов на этом потоке и показать, что я из себя представляю.

Курсы, начало: как впихнуть сон в перерывы между учебой, работой и домашкой

На курсах собирались группы по 8-10 человек. В программе была разработка на iOS и Android — нужно было выбрать направление. Я доверил выбор своему другу и одногруппнику, которого тоже сподвиг пойти на курсы. Я рассчитывал, что если нас не возьмут на работу, то мы сможем придумать что-то вдвоем. И для блага будущего проекта стоит выбрать разные направления.

В итоге, он стал учиться Android-разработке, а меня отправил на iOS. Смешно, что я пошел на курсы iOS-разработки без мака, без айфона. Я до курсов ни разу и не пользовался собственным айфоном — у меня был Xiaomi mi5. И первый «яблочный» телефон у меня появился только спустя полгода программирования, когда удалось наскрести на него денег.

Когда я пришел на курсы, мне дали базовый scope задач. Я быстро осваивал материал, и ближе к окончанию курса, когда часть не очень способных студентов отсеялась, я уже помогал почти всем с домашкой.

И тут меня поджидала еще одна проблема — доступ к компьютеру. Я работал на Mac mini, который находился в университете, при котором работал наш колледж. У DIIT был отдельный кабинет, где проходили занятия по iOS и Android-разработке: в понедельник и среду — iOS, во вторник и четверг — Android. Получается, для самостоятельного изучения оставались дни с пятницу по воскресенье и время после занятий. С работой это было трудно совместить, я уж молчу про учебу в колледже.

Класс в колледже, где проходила стажировка от ребят из DIIT

А я, конечно, работал — в фирме «Калибр», это местный пивной дистрибьютор. Устроился я туда между вторым и третьим курсами колледжа. Я выполнял обязанности оператора 1С — по сути, мне нужно было помогать логисту с подготовкой документов: накладными, «закрывашками». Всего я проработал там 1,5 года.

Зарплатная вилка менялась нечасто. Сначала мне платили 13 тысяч, но спустя 5 месяцев я сказал, что устал, и мне нужна прибавка. Подняли до 14 тысяч (и на том спасибо!). Потом был период, когда нас сильно завалили — я приходил на работу в 18 вечера и уходил в 1-2 ночи. Тогда мне еще раз подняли зарплату, уже до 15 тысяч.

А потом началась всякая неразбериха с партнерами и сменой дистрибьюторов. В итоге меня перевели в другую контору, и там из-за ужасного хаоса в базах данных я мог работать с 18 вечера до 6 утра. То есть 12 часов работы, пара часов сна — и вперед, на пары.

На учебе, конечно, была жопа. По правилам колледжа, разрешалось пропустить до 50% занятий — но если прогуливаешь больше, тебя сразу должны отчислить. К счастью, никто этого не делал — все доходило до того, что зимнюю сессию можно было пересдать в мае. Часть зачетов я получил только потому, что получилось уговорить преподавателя и доказать, что я пропускал занятия не просто так. Главным аргументом была работа.

Челлендж: купить макбук студенту в Дагестане

Мне не нравилось, что я так сильно зависел от университетских компов. Нужно было выкручиваться и покупать мак. Рисковый шаг для всех начинающих прогеров, а в моем случае — рассрочка на 2 года и ноутбук, который стоит как ~10 моих зарплат на тот момент. Для многих 100 тысяч российских рублей покажутся не такой уж большой суммой, но для меня, работающего с 16 лет за зарплату в 13-15 тысяч рублей, это были ОЧЕНЬ большие деньги.

Я понимал, что мне нужно учиться с 8:30 до 15:00 и работать с 18:00 до 24:00 (а иногда и до утра). В промежутке — в основном, в дороге — я должен был что-то изучать. Так что пришлось разориться на собственный макбук. Только так можно было попасть на стажировку.

Невероятно, но факт — мне это все-таки удалось. По итогу курса я все же попал на работу в DIIT Center — единственную дагестанскую IT-компанию с мобильной разработкой.

Это был мой билет в светлое будущее — было важно его не просрать.

Работа в DIIT и первые факапы

Обычно на стажировку в DIIT приходят люди, которые вообще НИЧЕГО не знают. Ну, может быть, только циклы. Стандартная стажировка длится от месяца до трех — ну, или до тех пор, пока кандидат не будет готов к настоящим продакшн задачам. Мне для начала дали несколько задач, в основном про архитектуру (MVP), кнопочки и Label.

Первое время я не понимал язык людей, с которыми работал. Дикая смесь русского, английского и различных терминов — в это сложно въехать людям, которые еще «не в теме». Спасибо товарищам, которые поддержали в этот момент! Отдельный респект Марату Магомедову за то, что поверил в меня, Арсену Абдурашидову и Магомеду Магомедову — за прием новичка в свой клуб «анонимных алкоголиков», Ризвану Гаджикеримову и Расулу Татаеву — за обучение и помощь по всем вопросам.

Спустя рекордные для компании три недели моя стажировка закончилась, и я стал полноценным сотрудником компании. Еще через два месяца меня взяли в команду, которая работала с отдельным проектом, который, к сожалению, находится под NDA, так что детали я рассказать не могу.

Иногда на работе мы засиживались допоздна. Я настолько редко фоткаюсь, что меня буквально заставили сесть за чужой мак ради фото.

Я сильно воодушевился, потому что к проекту подключили бест оф зе бест сотрудников — back-end, android, PM — и МЕНЯ. Мы работали три месяца, а потом из-за закрытия проекта вернулись в свои команды. Начался простой.

На тот момент все нормальные проекты были разобраны, поэтому все, что мне оставалось — закрывать баги, причем все сразу. Доходило до смешного — я мог ротироваться между пятью разными проектами за неделю и без какого-то кодстайла. Только в конце месяца мне дали нормальную задачу, и как раз ее я не доделал! Все бы ничего, но оплата была сдельной — сколько задач закрыл, столько денег и получил.

Ставка джуна была 250 рублей в час. Я за месяц получил ровно 6250 рублей — в два раза меньше, чем в пивной компании! И это та самая престижная и перспективная профессия программиста, о которой все говорят?!

Я сидел и думал — че делать-то? Мне нужно было отдавать рассрочку за мак, но тогда оставшихся денег мне не хватило бы даже на дорогу до работы. Это сильно ударило по моей самооценке. Как это так — два года я сам все делал и сам себя содержал, а теперь мне нужно занимать деньги? Но таковы трудности роста — другого выхода у меня не было. Оставалось надеяться, что все жертвы окупятся в будущем.

Я остался работать в DIIT. Спустя 10 месяцев, из-за ухода некоторых ребят, меня назначили тимлидом iOS-направления. Да, тимлид-джун! Звучит смешно, но по меркам Дагестана я был каким-никаким миддлом — а компании в тот момент очень нужен был человек с опытом, чтобы обучать новичков.

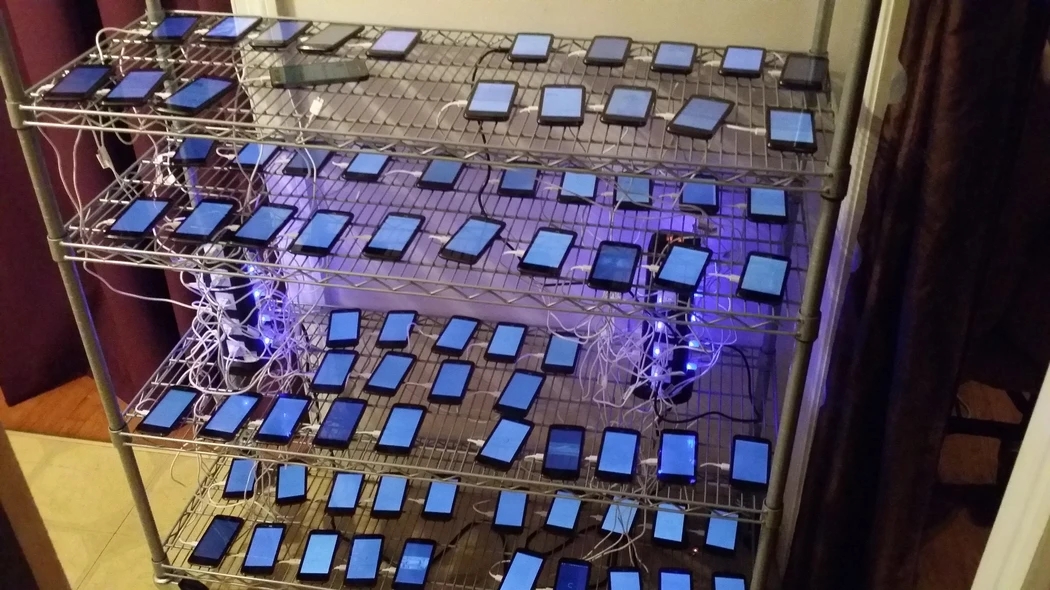

Иногда мы проводили общие лекции/презентации для всех сотрудников компании. На фото лекция про iOS-разработку

В Дагестане компании-разработчику очень сложно найти высокооплачиваемые проекты и платить сотрудникам «московские» зарплаты. Честно говоря, это невозможно, наверное, как и в любом другом регионе нашей необъятной страны. Поэтому все смышленые разработчики в DIIT, набирая какой-то опыт, уходили из компании и ехали покорять столицу — иногда и другие города, но 90% ехали в Москву — зарабатывать бабки.

Я не стал исключением. В DIIT была безумная текучка народу. В сентябре-октябре уехало четыре моих знакомых, с двумя из которых я очень близко общался. В один момент я почувствовал себя очень одиноким — только я и куча новичков, которых нужно учить. В мою голову закралась мысль о переезде в Москву — основным мотиватором, конечно, были деньги.

Переезд в Москву: непонятно, далеко и холодно

Когда увольнялся последний оставшийся iOS-разработчик, кроме меня, я тоже подумал, что пора двигаться дальше. Я несколько дней писал своим друзьям, которые уже уехали в Москву, спрашивал, как обстановка, как они обустроились на новом месте. Я сильно переживал и метался, а они были готовы купить билет в Махачкалу, чтоб отвесить юному товарищу пару хороших ЧАПАЛАХОВ (пощечина — прим.ред.). В конце концов, они привели меня в чувство, и я начал поиск работы в столице.

За месяц поиска работы я отправил чуть больше 40 откликов на разные вакансии. Когда мне не отвечали, я очень переживал, думал — может, хотя бы в тестировщики податься? Привет всем HR-ам, которые видели мое резюме и не отвечали. Я предложил свою кандидатуру 40 компаниям, и знаете что? Мне ответили только 4. До собеседования дошло только в двух местах.

На заметку всем, кто пойдет моим путем — не ждите, что вам будут хорошо отвечать на ваши отклики. Рассылайте как можно больше резюме, рассчитывайте на конверсию не больше 10%. И не сдавайтесь — ваша компания рано или поздно вас найдет!

Возвращаясь к моим собеседованиям — первое я, увы, завалил по полной. Наверно, сказалось волнение и отчаяние, которое накатило в процессе ожидания.

Второе собеседование было в аутсорс-продакшне FINCH. С момента отклика до собеседования прошел месяц: я уже почти опустил руки, просрал собес в одной компании и сидел над тестовым заданием от другой.

Собеседование в FINCH было нервным — я ответил только на 60% вопросов. К концу собеседования я уже совсем упал духом, думал остаться в Махачкале, сидеть на жопе ровно и не прыгать выше головы — и тут мне говорят «Даниял, думаю, ты нам подходишь, сколько ты хочешь получать?».

Внутри все просто перевернулось! Но я понимал, что на многое не стоит рассчитывать с таким собесом — и я назвал сумму, которой со скрипом хватило бы на жизнь в большом городе. Мне тут же сделали предложение, даже увеличив названную мной сумму, и я незамедлительно согласился.

Это прекрасное чувство, когда твои навыки оценивают по достоинству — для меня на тот момент это было просто ОГРОМНАЯ сумма. Для справки, за год в Дагестане я заработал две такие зарплаты. Бедные регионы богатой страны!

Спустя три недели я уже был в Москве. До этого я выезжал из Дагестана один раз — в Астрахань, но так как это было в детстве, я ничего не помню. То же самое с самолетом — летел в первый раз. Так как дело было в январе, я безумно мерз, хотя разница в температуре была всего 5-10 градусов.

В аэропорту я понял, что ехать до моего нового дома по расстоянию столько же, сколько у нас ехать из одного города в другой — 100 км. Это дорога из Шереметьево до Первомайской. Махачкала тоже большой город-миллионник, но его можно полностью обойти за 12 часов пешком — поэтому московские расстояния меня порядком впечатлили.

Первый месяц в Москве был тяжелым — я понял, как сложно найти квартиру в столице. Поначалу мы вместе с друзьями из DIIT жили впятером в квартире 30м². Это была однушка, переделанная в подобие двушки. Там была гипсокартонная перегородка и три кровати, одна из которых была «подвешена».

Чуть позже я с двумя друзьями переехал в другую квартиру. Тогда я понял, как быстро утекают деньги. С собой у меня было 50 тысяч, которые я долго собирал. Мы отдали за квартиру половину залога, а потом поехали в икею докупать то, что нужно — и денег как не бывало!

Пацан к успеху пришел

В первый месяц работы ребята из

FINCH постоянно менторили и обучали меня. Мне рассказывали про проекты, кидали статьи и книги, которые я должен был прочитать. Спустя несколько недель изучения документации меня посадили делать проект, которым пользуются тысячи людей.

Первую зарплату я просто не смог посчитать — я перекладывал купюры из руки в руку. Тогда мне было не важно, точная ли там сумма, их просто было МНОГО для меня.

Как я упоминал выше, ехал я в Москву за деньгами — но удивился тому, что они с трудом могут удержать меня в этом городе. Как бы мне ни было кайфово работать в очень хорошем офисе с классными коллегами, все выходные проходили в воспоминаниях о родном городе.

Таких как я называют «маменькиными сынками» — меня сильно держат родственные узы. Мне было трудно приехать в Москву — ведь я всю жизнь жил с семьей, а не один. А тут ты приезжаешь в чужой город, и тебе нужно все делать самому — работать, заниматься домом, а родственники, которые могли бы поддержать, далеко. До мая я думал — может, вернуться домой? Но в итоге решил, что опыт, который я получу здесь, я больше нигде в России не получу. Я должен оставаться в Москве.

Прошло уже полгода с того момента, как я переехал в столицу. Жилищные условия постепенно улучшаются: позволить себе снимать квартиру один я пока что не могу, живу в Печатниках вдвоем с другом. Часть зарплаты я отправляю домой, стараюсь раз в два месяца приезжать к семье. Говорю, чтобы мама бросала свою работу за копейки — но, по ее словам, тогда ей будет скучно.

Теперь в приоритете у меня тот бесценный опыт и знания, которые я могу получить здесь. Сейчас я на пороге новых свершений, нового звания в программировании — и, в принципе, всем доволен.

Вместо вывода

Всех, кто хочет чего-то добиться, призываю — не надо сидеть и ждать манны небесной, не надо сомневаться, не надо думать, что может пойти не так. Берите и делайте! Я просто пошел и сделал все, что от меня требовалось, ничего сверхъестественного — учился, работал, выполнял все задания. И теперь я зарабатываю хорошие деньги, работаю в ТОПОВОЙ компании и воплощаю в жизнь свои цели и мечты.

Фото в фирменном мерче компании

И немного о наболевшем. Большая проблема нашего государства в том, что в регионах нет денег. Поэтому такие ребята, как я и мои друзья, должны бросать все: семью, друзей, любимых — чтобы просто достичь чего-то в жизни.

Мой совет — развивайте себя и развивайте свои регионы, чтобы можно было работать и строить карьеру там. Есть много таких же людей, как я, бегущих в столицу, в которой их не особо рады видеть, чисто ради денег. Возможно, в будущем я вернусь в Махачкалу, чтобы «поднимать» там IT-сектор — но пока мне важно набраться опыта в столичной компании.

Место для респектов: спасибо Александру Антонову за то, что я все-таки попал в FINCH, Антону Логинову за то, что терпит и обучает — да и в принципе всей команде, в которой я работаю сейчас. Радует, что на рынке IT есть компании, не подверженные стереотипам — и надеюсь, таких будет становиться все больше!

Let's block ads! (Why?)

Каков юридический статус систем ИИ, создающих музыку

Каков юридический статус систем ИИ, создающих музыку Рождение и смерть альбома: как менялись музыкальные форматы за последние 100 лет

Рождение и смерть альбома: как менялись музыкальные форматы за последние 100 лет Как IT-компания боролась за право продавать музыку

Как IT-компания боролась за право продавать музыку От критиков к алгоритмам: как демократия и технократия пришли в музыкальную индустрию

От критиков к алгоритмам: как демократия и технократия пришли в музыкальную индустрию Исследование: музыка вредит творческому мышлению — обсуждаем альтернативные мнения

Исследование: музыка вредит творческому мышлению — обсуждаем альтернативные мнения На IT-фестивале представили первый «гендерно-нейтральный» голосовой помощник

На IT-фестивале представили первый «гендерно-нейтральный» голосовой помощник