9 июня в нашем инстаграм-аккаунте прошел прямой эфир с CTO Okko Алексеем Голубевым и вышла настоящая прожарка — 99% вопросов составила критика сервиса.

Из-за этого получился скорее более продуктовый рассказ, чем технический, но по сложившейся традиции, мы выкладываем все расшифровки и записи эфиров.

***

Меня зовут Алексей, я – технический директор компании Okko. Вопросов накопилось много, я постараюсь ответить на все.

Когда в онлайн-кинотеатрах будут идти премьеры параллельно с обычными кинотеатрами? Индустрия до сих пор не готова?

Давайте расскажу, как в принципе работает индустрия лицензирование кино.

Основной доход с фильмов получается во время проката в кинотеатрах. Все студии, особенно голливудские игроки, хотят как можно дольше привлекать в кинотеатры как можно больше людей.

Раньше следующим этапом было открытие прав на продажу DVD/Blu-ray, и только после этого открывались права на цифровой показ. Несколько лет назад картина начала меняться под давлением сервисов, предоставляющих услуги цифрового показа – Netflix, в первую очередь. Мы, конечно, тоже вносим свой вклад. Каждая большая студия проводит аудит онлайн-сервисов на предмет соответствия стандартам безопасности, и я стараюсь добавлять в переговоры тему сдвига релизного «окна». Сейчас ситуация уже сильно изменилась: например, фильмы русских студий часто поступают в онлайн-кинотеатры еще до конца проката в физических кинотеатрах.

Кстати, на наш рынок повлияла пандемия: те же «Тролли» поступили в физический прокат за неделю до закрытия всех кинотеатров, а после закрытия – сразу же появились на онлайн-площадках. Индустрия двигается вперед, но крупные компании – Sony, Fox и прочие Paramount – довольно консервативны сами по себе, и их точка зрения меняется медленно.

Онлайн-окно на продажу (с ценами порядка нескольких сотен рублей за каждый фильм) открывается сейчас спустя несколько месяцев после начала проката в кинотеатрах, и только спустя еще несколько месяцев (иногда – через год) открываются права на показ фильма по подписке. Многие спрашивают о том, почему определенный контент доступен только с прямой оплатой, а не по подписке – собственно, так устроено лицензирование кино. Музыкальные каталоги лицензируются по-другому. Часто большие студии еще и не дают выкладывать в подписку весь каталог одновременно и требуют ротации контента – то есть, вместо того, чтобы открывать доступ ко всем имеющимся фильмам одновременно, подписка открывает доступ к сменяющим друг друга наборам фильмов.

Когда у пользователя будет возможность вернуть деньги за неинтересный фильм? Например, с привязкой размера возвращаемых средств к процентам просмотра фильма.

Это интересная фича, и многие онлайн-кинотеатры о ней думают. Правда, надо понимать: за подобный прерванный просмотр фильма (обычно – начиная с 20%) правообладатель все равно должен получить средства целиком, и в таком случае их должен будет заплатить кинотеатр. Может быть, такие затраты можно будет причислить к маркетингу. Общая цена фильма состоит из минимальной витринной цены (её тоже может устанавливать правообладатель), отчислений за подписку/продажу и отчислений вендорам платформ (например, Samsung SmartTV) – то есть, за каждый просматриваемый фильм кинотеатр обязан заплатить как кинокомпании, так и вендору платформы.

Почему все так сложно с правами на фильмы? Почему не как с музыкой?

Сейчас, чтобы смотреть все новые фильмы и любимые сериалы, приходится подписываться на все стриминговые сервисы. Есть шанс, что в будущем это изменится?

Более того – сверх подписок часто приходится доплачивать. Netflix, который держится исключительно в подписочном формате, решает эту проблему собственным производством контента, доступного только по подписке Netflix.

Пользователи приходят к ним именно за этим контентом, а не за тем, который будет доступен через год после выхода. Возможно, в будущем что-то изменится, но пока не видно перспектив к прекращению фрагментации контента (например, на американском рынке он разделен между Amazon, Hulu и Netflix).

Можно ли в Okko получить копию фильма без DRM, без дубляжа, с оригинальной дорожкой и качеством?

Исходник может занимать терабайт, например – поэтому истинного исходного качества точно не может быть. Мы готовим контент для доставки по Интернету, режем на несколько разных битрейтов, кодируем 264/265 кодеком и выкладываем на разные платформы в разных типах стримов с поддержкой адаптивного битрейта. То есть, пока вы смотрите на мобильном приложении через WiFi, битрейт подстраивается под скорость подключения около 6 Мбит/с, а если вы выносите телефон за его пределы, качество падает до SD. Без DRM – нельзя, это запрещено договорами с правообладателями. Хотя некоторые фильмы защищать не надо – в основном, те, которые считаются частью мирового наследия. Фильмы с оригинальной дорожкой у нас есть, но я не могу сказать точно, сколько их.

Работаете архитектором и CTO одновременно?

Да. Я рос в Okko от разработчика на Android до full stack, back end, архитектора, системного архитектора и CTO. Мне нравится заниматься архитектурными вещами. Я стал CTO 3 года назад, и это развязало мне руки: теперь я могу комфортно и быстро продвигать новые технологии, которые я сам вместе с нашей командой архитекторов считаю нужными, необходимыми, перспективными.

Сейчас я продолжаю решать архитектурные вопросы по новым кускам системы и по расширению старых кусков. Техническая команда Okko еще год назад составляла не больше 40 человек, и на каждую платформу приходилось немного (мы работаем с мобильными Apple и Android, смарт-ТВ, Web и так далее); при том, что для работы с клиентами и тестирования нужно 10-15 человек, а также люди нужны на DevOps, поддержку облачной инфраструктуры, разработку серверного ПО и различных внутренних (backoffice) инструментов, не видных пользователю. На малое количество людей приходится большая плотность знаний – и для того, чтобы правильно развивать систему дальше, нужно правильно привлекать эти знания. Я стараюсь максимально делиться своими собственными знаниями.

Разделяются ли эти роли?

Формально да. Отдельные документы пишу как архитектор, другие – как CTO. В разных компаниях в понятие роли CTO вкладываются различные смыслы; где-то он больше «технический», где-то – «директор». Я думаю, в более крупных компаниях обычно главенствует вторая составляющая – там больше организационно-бумажно-процессной нагрузки. Наша культура развития больше напоминает культуру стартапа: я до начала этого года явно был главным образом «техническим». Сейчас у нас появились крупные акционеры, типа Сбербанка, и с ними пришло много организационной работы, но пока удается справляться с ней минимальными усилиями.

Будет ли сравнение Okko с аналогичными сервисами?

Вопрос не до конца понятен. В технической части – я не знаю, как устроены другие сервисы. Наш главный конкурент – ivi, команда у них всегда была больше, и некоторые моменты развития у них проходили быстрее. Сейчас быстрее развиваемся мы – за счет поддержки акционеров; наверно, будем вырываться вперед.

Зачем мне платить за вашу якобы премиум-подписку? У ivi есть годовые подписки, они гораздо дешевле

У нас теперь тоже есть годовые подписки. Сравнивать матрицу цен – это работа маркетолога, и наверняка есть сайты, на которых можно прочитать подробное сравнение. Борьба за пользователя идет скорее на уровне продуктов, а не за счет цен, 100 рублей обычно роли не играют, когда человек принимает решение.

Решил посмотреть фильм – оказалось, что в подписку не входит, нужно платить дополнительную сумму; сколько – непонятно, без регистрации не узнать

Это вопрос решаемый — я обязательно передам продуктовой команде, чтобы цены были видны до регистрации.

Я вот вначале подумал что въедливая, умная и капризная аудитория Хабра не входит в целевую группу Okko, потом сообразил, что как раз таки входит, а нецелевая группа смотрит обычное ТВ, а не шарится по стриминговым сервисам.

Если бы Okko пошло по пути тех же трекеров в плане предоставления контента – то есть, с возможностью выбора нюансов, озвучки, качества – то результат мог бы быть хорошим, за удобство доступа вполне можно было бы платить. Почему вы так не делаете?

Мы стараемся делать максимальное контентное предложение для тех фильмов, которые есть: с дорожками, субтитрами, максимально доступным качеством. Но надо понимать, что, например, для архивных фильмов сложно найти исходник, и студии их не всегда предоставляют.

Почему в разделе «аниме» 50 фильмов, и только один от Миядзаки?

Честно скажу, меня это тоже возмущает. И я уверен, что наш отдел контента слышит наши стенания и уже работает над этим.

Когда сервисы уже дотянутся до уровня торрентов с выбором озвучки и качества, театральных и режиссерских версий, будет ли киноклуб?

Киноклуб – это совместный просмотр? У нас есть такие идеи, сейчас идет исследование — студенческий рисерч-проект, чтобы попробовать. А театральные и режиссерские версии уже есть, если их поискать.

Почему в России нет своего Netflix, который бы продюсировал кино?

На самом деле и ivi, и Okko уже работают над собственным продакшеном. У нас в сервисе есть сериалы, которые были спродюсированы и сняты полностью в Okko Studios. Это будет раскручиваться дальше – в эту игру начинают играть многие, и собственный продакшен в будущем должен стать главным отличием цифровых кинотеатров друг от друга.

Все контракты с большими студиями примерно одинаковы; иногда кто-то переплачивает огромные суммы, чтобы показать новинку на неделю раньше, но экономически это невыгодно – чистый маркетинг.

Реально ли иметь сервис, где будут ВСЕ любимые фильмы? Не хочу 10 подписок

Пока придется иметь много подписок. На Западе сейчас обычное дело – подписываться на 2-3 сервиса, или более. Издателям ведь мало ваших денег за билет — они хотят отчислений от подписок каждого цифрового кинотеатра, для этого используются эксклюзивы и ротации. Такова реальность — я называю это звериный оскал капитализма.

Почему нельзя сделать подписку как у Netflix, в которую входит все?

У них не входит все. Netflix находится в приоритете у студий и получают особые условия, так как они – крупнейший мировой игрок. Netflix главнее, чем некоторые студии. Наш рынок вообще считается задворками лицензионного контента, у нас все всё пиратят, и студии от этого нервничают – некоторые новинки до нас не доходят.

Некоторые кинотеатры требуют несколько подписок одновременно: для основного контента и для сериалов от HBO, например. Почему?

Это история, которая диктуется правообладателями — в противном случае они вообще не дадут контент. Тут мы сами в ловушке.

Почему даже в премиум-подписку не входят все фильмы?

Новинки должны пройти этап продажи просмотров, это тоже устанавливает правообладатель.

Откуда берутся цены на фильмы?

Оттуда же, из контрактов. Плюс затраты на маркетинг и другие наценки.

Подписка и так платная, почему посреди сериала реклама какой-то мыльной оперы? Это решение правообладателя?

Первый раз об этом слышу. Я не видел таких контрактов с правообладателями, в которых были бы вставки, если не считать трансляции Премьер-лиги — это единственное партнерство с рекламой. Может быть, с исходником что-то не так.

Кстати, насчет «Хоббита». Он не новинка, но он входит в бэк-каталог. Каталог ротируется большими студиями; должны быть «окна», чтобы зрителями постоянно предлагались разные фильмы, чтобы всякому старью давать больше ценности.

Почему такая высокая цена? Оптимум с ширпотребом – 399, премиум в два раза дороже – 799, и то отдельные фильмы приходится докупать

Это больно, но я не знаю что на это сказать — такое ценообразование.

Мы привыкли к тому, что все доступно бесплатно, у нас всегда есть такой выбор в голове, и мы его всегда имеем в виду.

В США люди боятся качать торренты, потому что считают, что их могут поймать – то есть, у них такого выбора нет. Это вопрос менталитета. Меня знакомые американцы иногда просят скачать что-то с трекеров и привезти на диске.

На новинки обычно хожу в кино, но иногда люблю смотреть старые фильмы. В Кинопоиске они входят в подписку, и половину он дает посмотреть бесплатно (с рекламой), а в Okko такого нет. Почему?

Мы принципиально не добавляем рекламу в фильмы, поэтому нельзя посмотреть бесплатно. Это наша позиция. Мы – премиальный сервис, и наш пользователь платит за то, чтобы спокойно посмотреть кино без рекламы.

То, что Кинопоиск включает в подписку: у Кинопоиска просто иной контракт с правообладателем. Есть отдел контента и лицензирования у каждого стримингового сервиса, каждый договаривается как может, что можно включить в подписку. Разные контракты часто заключаются на неодинаковых условиях, включая различные маркетинговые ходы.

Почему некоторые сезоны сериалов платные при наличии подписки в Okko? У меня часто бесплатен по подписке только первый сезон

Да, последующие сезоны могут не входить в Оптимум. Бывает так, что сезон по условиям контракта не может идти вместе (бандлироваться) с другим контентом.

Фильмы в 4К только платные. Почему так?

На самом деле нет, есть подписка 4К. Она входит в Премиум.

Почему нельзя отказаться от фильмов, которые не могут быть включены в подписку, и/или сотрудничать с правообладателями?

Потеря денег.

У Netflix нет платных фильмов, можно по подписке смотреть все, что доступно

Да, но зато у них нет The Other Lamb.

Почему у нас нигде нет так, как на Netflix?

Ну, пока нет. Боремся с пиратством. Каждая копеечка важна с точки зрения выживания сервиса.

Наше население неплатежеспособно, сравните уровни жизни за рубежом и здесь — вот и ответ на пиратство?

Вопрос не ко мне, не могу ответить. У вас скоро будет возможность проголосовать, попробуйте что-нибудь изменить.

Кинопоиск охватывает сторонние студии озвучки, разрешает матюки, ценник ниже, делает свои проекты, нет путаницы с подписками, что предпринимает Okko?

Кинопоиск действительно активно развивается и привлекает абонентскую базу за счет специальных предложений. При меньшей базе проще делать цены ниже, потому что ниже издержки на маркетинг. Когда пользователей уже не несколько сотен тысяч, а миллионы, то маркетинговые издержки и выплаты правообладателю становятся выше. Чистая экономика. У нас тоже много акций, и раньше они были более агрессивными; сейчас есть другие каналы привлечения. Моя задача – сделать так, чтобы эти акции работали.

Правда ли, что, чем больше сервисов, тем больше шансов, что на них кто-то подпишется?

Не знаю. Думаю, выживает несколько подписок в итоге.

Как будет развиваться Okko? Вы продолжите размазывать контент по сервисам, заманивая эксклюзивами?

Да, мы все это будем делать, это вопрос взаимоотношений с правообладателем и правил работы с индустрией. Голливуд он такой, жестокий.

Почему приставка Okko Smart Box продается с обрезанным функционалом? Чтобы получить AndroidTV, приходится шаманить

Да потому что она стоит 2 рубля. Поэтому там порезан функционал и оставлены Youtube, Okko и еще что-то. Можно заплатить за Xiaomi, если нужен полноценный Andoid TV. Это всегда так работает с андроидом: покупаешь его, рутуешь, ставишь торренты и у тебя все хорошо, но это требует усилий

Онлайн-кинотеатры больше рассчитаны на людей, которые готовы заплатить лишние 100 рублей, чтобы не бегать с флешкой от торрента до смарт-тв.

Стоковая прошивка запускает Youtube в FullHD. Зачем там начинка, которая годится для 4K, но не показывает 4K?

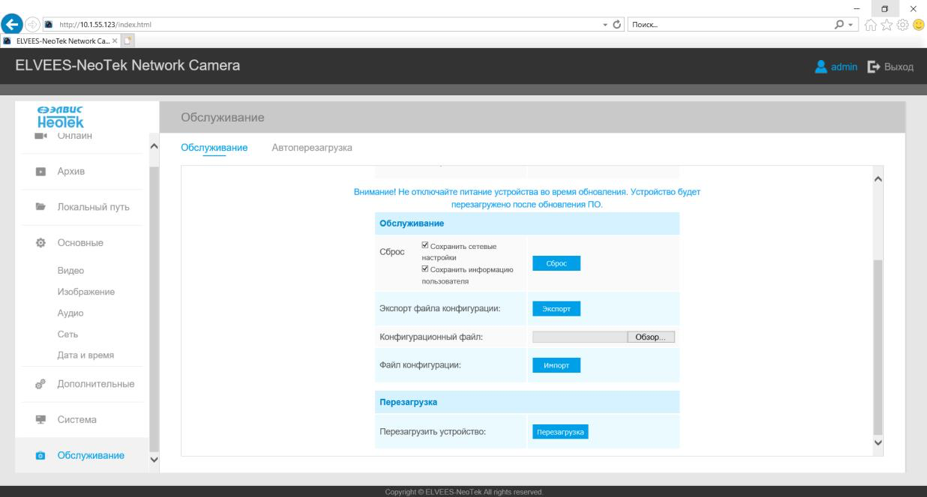

Я думаю, в этом году будет обновление приложения Okko для Smart Box, в котором будет 4K. Это, опять же, вопрос лицензирования. Чтобы получить разрешение на показ фильмов от Disney или Warner в 4К, нужен технический аудит устройства командой по защите контента на предмет наличия лицензированного DRM – например, Microsoft PlayReady, Google WideVine, Apple FairPlay и еще нескольких. Они должны быть реализованы с хранением ключей не в памяти приложений, а в hardware trusted zone – то есть, чтобы защищенность обеспечивалась на уровне железа, а декодированное видео тоже защищалось на уровне железа вплоть до выхода HDMI, где будет работать HDCP, который покажет черный экран при подключении китайского сплиттера. Smart Box еще не прошел лицензирование, но процесс идет – вот это вот 4К лицензирование в том числе находится и в моих руках и я этим обязательно займусь, завтра утром ;).

Что планируется по спорту? Новый ЧМ по футболу, Лига чемпионов, другие виды?

Сейчас я как раз стараюсь больше сосредотачиваться на спорте. Там более интересные технологии, на мой взгляд; кроме того, в этой области можно развиваться наравне со всем миром. Понятно, что Okko и остальные отечественные игроки сильно отстают от Netflix в области фильмов, но, если говорить о спортивных over-the-top трансляциях, то Okko не насколько отстает от ESPN+, например, как от Netflix. У нас есть шансы догнать и определять этот рынок. 17 июня рестартует Премьер-лига, там будут варианты просмотра в оригинале (с пустым стадионом), либо с наложением звуков стадиона. Приостановленный MLS – американская лига обычного футбола – тоже будет возрождаться. Других футбольных лиг пока не предполагается, потому что это требует серьезного расширения штата комментаторов; они у нас круты, но для одновременной трансляции итальянского и испанского чемпионата потребовалось бы больше людей – и за эти кадры пришлось бы бороться с Матч-ТВ. Другие виды спорта будут, возможно – до конца года.

Иногда приложение Okko запускается на телевизоре LG минут 10, а ivi – стабильно быстро, почему?

Не могу ответить именно про LG. Мне кажется, что крупные и новые платформы смарт-тв обычно работают стабильно. Могут быть накладки со смарт-хабами и с работой самих платформ, но, если это воспроизводится, лучше написать в поддержку — мы поймаем багу и обязательно исправим.

Почему Okko не может сделать нормальное приложение для телефона?

Есть долг по мобильному Android, но мы над ним работаем. Приложение для Apple, как мне кажется, нормальное.

Почему в некоторых сезонах сериалов на PlayStation не работает звуковая дорожка? Почему версия для Android не запоминает тайминг и номер серии?

Должна запоминать. Напишите нам об этом, мы исправим. Возможно, что это Android 4.4 и у него специфика сложная — поищем.

Общее качество приложения отвратительно, почему не смогли повторить, имея перед глазами Amazon Prime и Netflix?

Сейчас техническая команда Okko – порядка ста человек. У Netflix года два назад было 600 человек, плюс отдельная команда – человек 200, которые занимаются рекомендациями (у нас – пять человек). Будем развиваться.

Какие выводы были сделаны после нестабильной работы трансляции матчей Премьер-лиги?

Я довольно подробно коснулся этого и рассказал, с техническими деталями, на конференции HighLoad++ в конце прошлого года. Доклад доступен на Youtube и в виде PDF. Выводы были сделаны, платформа была улучшена.

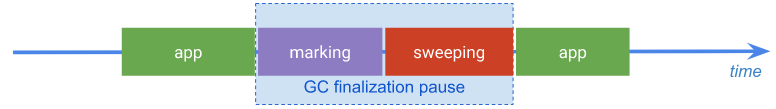

На самом деле, профиль нагрузки для трансляции ПЛ сильно отличался, и нам пришлось перед ее стартом, за три месяца – силами тех самых 40 человек, считая дизайнеров – создавать практически новый сервис. То, что мы его сделали – это уже достижение, на мой взгляд. Там карты сложились единственно верным образом с точки зрения технологий, сложности – не только программного, но и инженерного проекта, с собственным продакшеном и защитой контента.

Те три сбоя мы запомнили, мы сделали из них выводы, но без них нельзя было обойтись. В конце марта и в апреле, во время изоляции, была довольно высокая нагрузка от просмотра кино и трансляций концертов, а 17 июня мы ждем возвращения болельщиков. Я думаю, мы справимся с новой нагрузкой.

Как дела с приложением Okko Спорт на Xbox?

Работаем над этим. Некоторые моменты пришлось отложить из-за карантина, но скоро мы поедем в командировку в Москву и решим вопросы, которые требуют личного присутствия. Я сам очень волнуюсь за это и надеюсь, что к новому сезону ПЛ все будет готово.

Что за фигня с региональными дорожками и сабами? То есть, то нет, в разных приложениях по-разному

Это из-за разницы в форматах. Существует три основных.

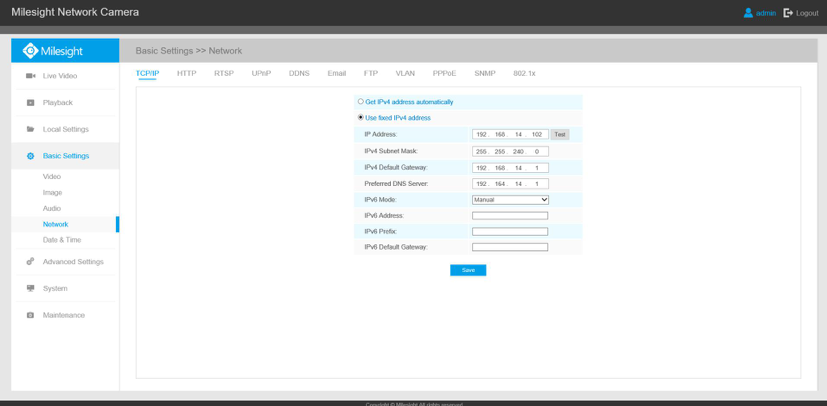

Стрим MPEG Dash – стандарт, в нем вроде бы должны все работать, в нем используется Common Encryption DRM. Работают все-таки не все: его поддерживают основные браузеры, но не Safari, также новые платформы смарт-ТВ: Samsung, LG (после 14-го года).

Еще есть Microsoft SmoothStreaming с DRM PlayReady, его поддерживают более старые платформы смарт-ТВ. Для Safari есть HLS с Apple FairPlay. Для Android – MPEG Dash с DRM WideVine. Есть некоторые устройства, где MPEG Dash используется с PlayReady от Microsoft; более старый вариант – PlayReady + Smooth Streaming, еще более старый – WideVine Classic (например, для старых LG).

Такая фрагментация стримов. Live еще более чувствителен к деталям в манифестах. На HighLoad я рассказывал о том, как базовые Live-энкодеры и пакеджеры тестируются у больших вендоров вроде Amazon: при этом используются только новые платформы, типа LG и Samsung после 14-го года, а на старые им плевать. Мы исследовали этот вопрос и понимаем, как поправлять манифесты, чтобы все работало; мы написали модуль для Nginx, который меняет их на лету для старых платформ.

Почему у Okko худшие субтитры? Нельзя менять шрифт, настраивать подложку, размер, убирать курсив, иногда целые предложения выпадают или показываются с задержкой

Мы работаем над этим.

Алексей: было много жалоб на приложение для PlayStation, выношу в отдельный рассказ о нашей работе в Sony

Sony оказывает большую поддержку – но именно разработчикам игр. Для них есть отдельные фреймворки, они могут использовать Unity и другие геймдевовские вещи, чтобы писать оптимизированный код.

Когда к Sony пришла компания Okko и сказала, что хочет разместить приложение на PS3 и PS4, нам сказали: вот WebMAF, пусть там крутится ваше HTML-приложение. Мы много усилий потратили на попытки уговорить Sony предоставить нам доступ к тому же API, которым пользуются геймдевы, но нам его не дали.

Дальше мы настраивали работу нашего Javascript/HTML через этот устаревший Web-движок. Я уже говорил, что Netflix может диктовать всем условия — так вот, им этот доступ Sony дали, у них приложение работает на их движке, который они контролируют.

На PS5, которая должна была выйти этой осенью, этот вопрос вроде бы улучшен и существует доступ к различным SDK для HTML-приложений. Еще там больше памяти — JS-приложение на PS4 вылетает именно из-за ее недостатка. Но, пока PS5 не вышла, мы ничего не можем сделать. Netflix работает на PS на том же уровне, что и игры, поэтому работает идеально.

Я сам пользуюсь Okko на PlayStation и страдаю каждый раз, когда вижу медленную загрузку. Это беда.

Почему сервис на PS4 только в 1080p?

4K просто не помещается в выделенную память на PS4.

Добавьте UFC на Okko. И пусть попробуют заняться организацией боев или спонсорством боев на манер РенТв, лично мня это интересует больше футбольчика

Не буду раскрывать все карты спойлерить.

Планируется ли закупать контент у стриминговые сервисов, недоступных на территории РФ?

Amazon Prime и Netflix не продают так свой контент.

Если бы они продавали, мы бы закупили.

Почему выбор качества в зависимости от платформы, на которой смотришь? Один сервис заявляет, что есть 4К, но его можно смотреть только на телевизорах от LG

Это связано со стримами. 4К – это HEVC/265, нужен MPEG Dash + Common Encryption. Это как раз поддерживают новые телевизоры от LG/Samsung и Android TV. Старые смарт-ТВ не поддерживают HEVC.

Есть проблемы на устройствах, на которых нормально смотрю другой 4K-контент. Почему так?

Да, есть сложности из-за того, что DRM – шифрование-дешифрование – добавляет необходимости в ресурсах. Из-за этого может не работать стриминг, которому требуется HEVC и DRM – даже в тех случаях, когда работает другой 4К-контент (mp4).

На какие технологии в IT следует обратить внимание тем, кто заканчивает ВУЗы в ближайший год? Что будет актуально в ближайшие 5 лет?

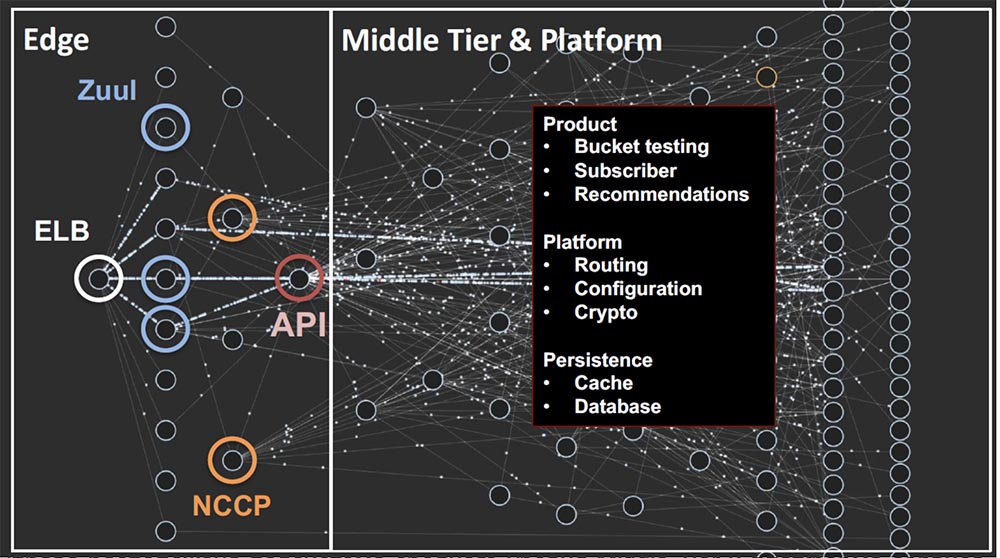

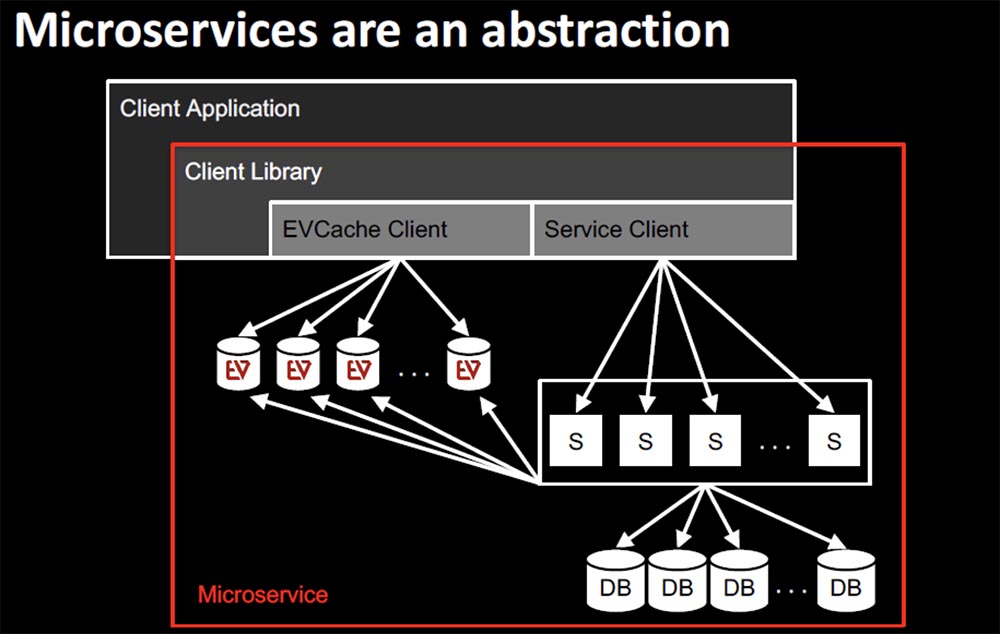

Сейчас актуально дробление.

Микросервисы, микрофронтэнды, раздельная разработка и развертывание, разделение бизнес-логики. Для этого есть специальные шаблоны проектирования и архитектуры.

Можно найти хорошие переведенные книги, есть отличный сайт microservices.io.

Не могу сказать точно насчет языков – в какой-то момент становится все равно, на каком языке писать. Есть Go, есть Kotlin. Важно уметь систематизировать свои знания и правильно задавать вопросы – хоть гуглу, хоть StackOverflow, а если в этих источниках нет ответа – то своим коллегам.

В ближайшие годы явно будут актуальны облачные сервисы. У нас не так много людей владеет построением решений на Amazon Web Services, например – в этом стоит прокачиваться. Хотя есть облака Mail.RU, Yandex или Sbercloud, они отстают от AWS и даже от Google Cloud или Azure.

Почему для Казахстана недоступен весь контент?

Мы уже работаем над лицензированием контента для Казахстана.

Что будет с моей истекшей из-за covid-19 подпиской на Премьер-лигу?

Мы продлили подписки на ПЛ до 31 июля. По предварительному календарю Лига должна закончить все туры до конца июля – соответственно, все подписчики смогут посмотреть ПЛ бесплатно. Ваша подписка должна сейчас работать. В сервисе есть много крутых архивных материалов, можно посмотреть какую-нибудь зарубу прошлых лет.

Честно платить за контент у меня получается только за игры, ПО и музыку, остальные медиа у нас еще в каменном веке по уровню сервиса. Почему?

Ну, я для музыки пользуюсь Spotify. Мне кажется, что всем нашим сервисам с музыкой до него как до луны пока – так что, с музыкой все так же плохо. Мы стараемся исправить ситуацию и сделать удобный сервис.

Как принять участие к киноклубе?

Когда у нас будет рабочий прототип, думаю, объявим какой-нибудь закрытый тест.

Как вы поддерживаете высокую доступность сервиса? У вас, как у Youtube, есть какие-то коробочки для провайдеров?

Пока наши коробочки есть только в Москве и Петербурге, оттуда мы раздаем контент. У нас еще есть партнеры – CDN-сети с региональными узлами по территории России, через них контент раздается дополнительно. Может быть, скоро коробочки будут и в других областях.

Сколько сил вкладывается в web?

Постепенно все больше. Там много маркетинговых историй, и дальше эта платформа будет развиваться. Хотя раньше я в неё даже и не верил – по мне, web = rutracker.

Почему нет возможности выбрать аудио дорожки и включить субтитры?

На некоторых фильмах они есть, хотя и не на всех. Мы работаем над этим.

Почему бы просто не дать возможность смотреть весь иностранный контент в оригинале с субтитрами?

Исходный файл добывается не так просто. Кроме того, это – довольно ограниченная ниша спроса, хотя мы, конечно, расширяем каталог фильмов с такой озвучкой и субтитрами. У нас сейчас есть бэк-каталог, который мы долго кодировали в тех форматах стримов, о которых я раньше упоминал – Dash, PlayReady/Smooth Streaming и так далее. Некоторое время назад мы начали использовать новый подход к подготовке контента: теперь мы кодируем один раз и используем just-in-time-преобразования для разных типов стримов. У нас эта технология уникальна, как я думаю, но Netflix тоже так делает; собственно, здесь каждый изобретает свой велосипед. Свой бэк-каталог мы перекодировали, но не всегда можно найти хороший исходник с оригинальной дорожкой. Надо понимать, что тайминг может не совпадать: даже видеоряд у оригинала и локализации немного отличается из-за разной длины реплик, например, и такая синхронизация требует дополнительной работы отдела контента – а этот отдел и так постоянно загружен добавлением фильмов.

Тяжело ли общаться с российскими правообладателями?

Мне кажется, легче, чем с остальными. У них же тоже российский менталитет, некоторым в принципе пофиг на защиту, хотя мы все равно ее ставим, чтобы никто не чувствовал себя обиженным по сравнению с голливудскими студиями. С которыми, к слову, общаться гораздо тяжелее.

Чего пользователям ждать от Okko в плане новых технических фич?

Технические фичи обычно не видны пользователю. Сервис постепенно становится стабильнее и быстрее, конечно, но пользователь обращает внимание, в основном, на продуктовые фичи. Технологическая команда поддерживает эти наработки – например, новый плеер для iPhone.

Назовите пару наиболее сложных технологических проблем

В рамках выпуска прямых трансляций WTT была куча проблем. Это стык с телевидением, и там люди бывают очень консервативны. У них до сих пор SDI-кабели торчат – если вы забыли, этот тот самый простой антенный кабель – и у них это основная поставка сигнала.

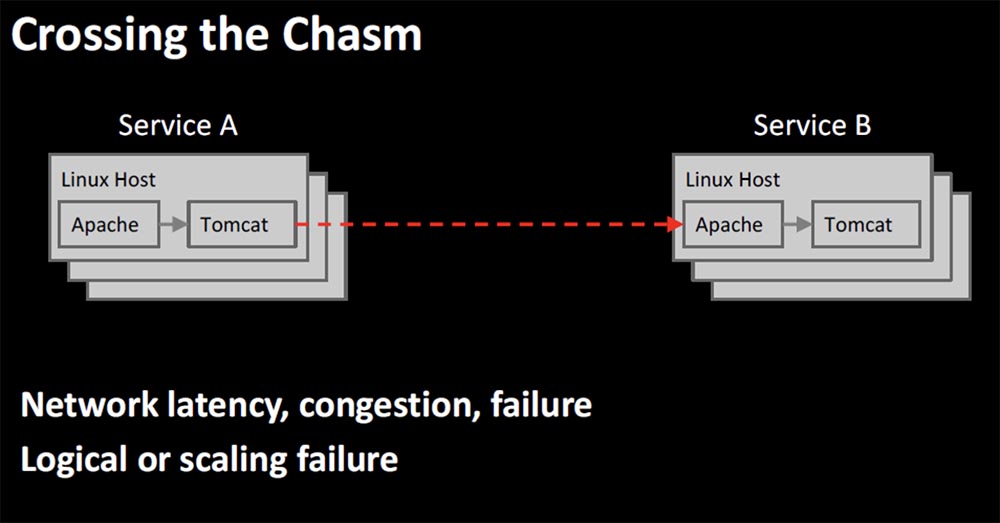

И это нужно было превратить в наши мегабиты в секунду; потребовалось серьезно напрячься, чтобы успеть в срок. Можно еще вспомнить вопросы нагрузки, кодирования just-in-time в разные стримы, «sale architecture» — чтобы клиенты ходили на разные back-end сервера, чтобы размазывать нагрузку и потенциальные сбои.

Какие языки стоит учить? Хочу Python и Java

Хорошие языки. Хотя нужные вещи на Python можно переписать на Go, а на Java – на Kotlin. В Kotlin больше синтаксического сахара, можно вместить 10 строк на Java в одну на Kotlin – конечно, на первый взгляд она будет совершенно непонятна.

На Go я пока серьезно не работал.

На Python что-то было – ну, он еще хорош порогом вхождения. Вообще, нужно думать от задачи; если пишутся микросервисы и вещи для backend – смотрите, где быстрее подзадачи, где лучше фреймворки, где сообщество более подходящее. На самом деле, архитектура и системный подход важнее.

Как развиваться разработчику, чтобы стать архитектором?

Нужно пробовать разное. Нужен системный подход, нужно постоянно искать новые проблемы, рассматривать задачи с разных сторон, рассматривать новые истории.

Не надо бояться – это то же самое программирование, тестирование, инженерия.

Когда джуниор две недели ищет пути решения задачи, погружается в тему, находит для себя новые знания, наконец решает ее за два дня и понимает, что тот, кто дал ему эту задачу, решил бы за два часа – это нормально. Этот путь нужно пройти. На чужом опыте здесь вряд ли получится научиться. Нужно все пощупать самому, посмотреть, как все компилируется, запускается, что всплывает под нагрузкой.

У архитекторов разные пути – я сам пришел в Yota в 2009 году как разработчик приложений для Android, там было много новых идей. В какой-то момент все начало разделяться, что-то уехало в Мегафон, а я остался разрабатывать видеосервисы.

Дальше мы стали писать приложения под Apple, часть переквалифицировалась под Objective-C; дальше – Windows Phone. Потом я стал изучать вещи под backend – хотелось, чтобы API было лучше. Мне стало понятнее, как взаимодействуют большие компоненты между собой, какая боль у клиентов, как ее решать через backend. От этого выросло мое архитектурное мышление – но это только один из вариантов пути. Можно приходить через test-driven development, например.

Зачем брать подписки, если то и дело из них пропадают фильмы и сериалы?

Пропадает обычно старое. Ну, какая разница – смотреть прямо сейчас первого Рокки, или второго? Они оба классные.

А что дальше?

Следующий прямой эфир пройдет во вторник,

23 июля, в 20:00.

Маркетолог RUVDS Сания Галимова будет отвечать на ваши вопросы в прямом эфире. Эфир пройдет в нашем

инстаграм-аккаунте.

Задать ей вопрос можно в комментариях к этому посту.

Что было ранее

- Илона Папава, Senior Software Engineer в Facebook — как попасть на стажировку, получить оффер и все о работе в компании

- Борис Янгель, ML-инженер Яндекса — как не пополнить ряды стремных специалистов, если ты Data Scientist

- Александр Калошин, СEO LastBackend — как запустить стартап, выйти на рынок Китая и получить 15 млн инвестиций.

- Наталья Теплухина — Vue.js core team member, GoogleDevExpret — как пройти собеседование в GitLab, попасть в команду разработчиков Vue и стать Staff-engineer.

- Ашот Оганесян, технический директор и основатель DeviceLock — кто ворует и зарабатывает на ваших персональных данных.

Let's block ads! (Why?)