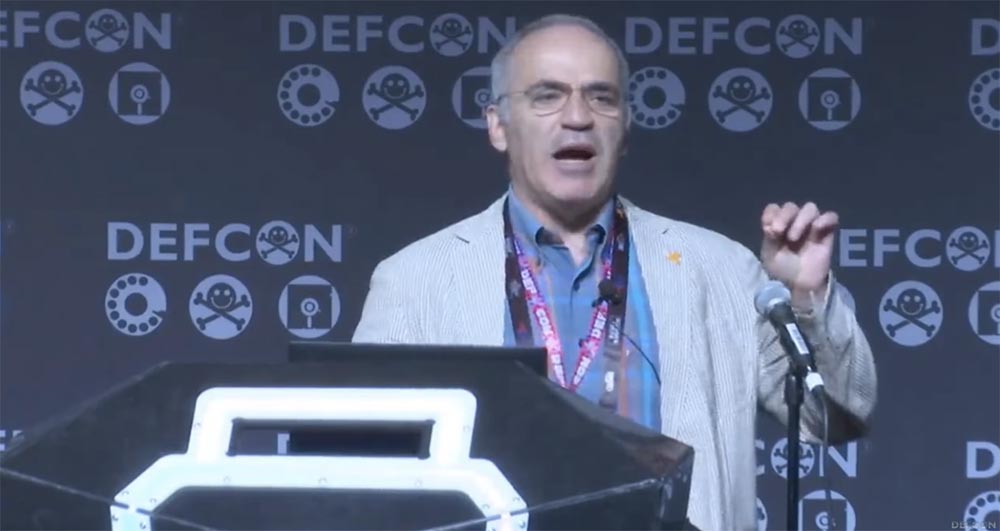

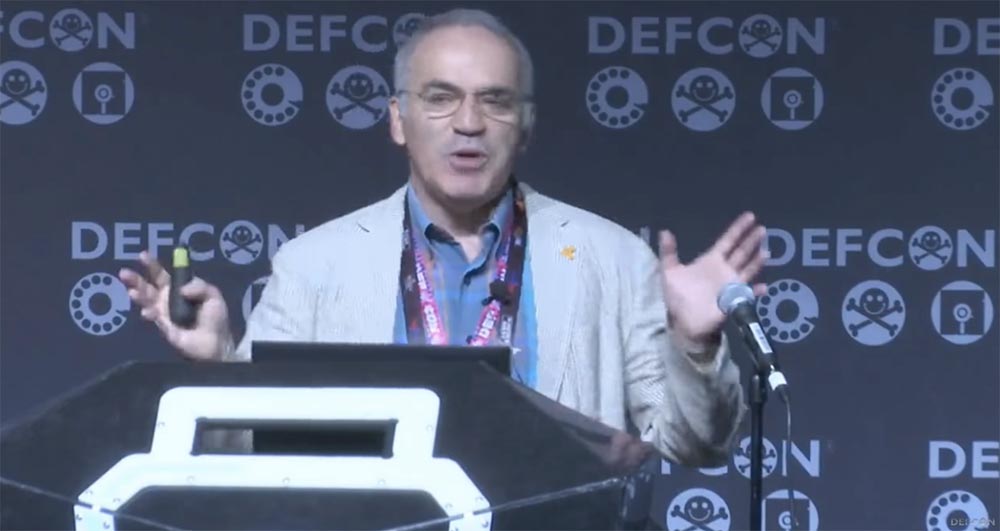

Для меня большая честь присутствовать здесь, но, пожалуйста, не нужно меня взламывать. Компьютеры и так меня ненавидят, так что мне нужно подружиться с как можно большим числом людей в этом зале. Хочу привести один маленький пустяк из моей биографии, интересный для американской аудитории. Я родился и вырос на самом юге страны, прямо рядом с Джорджией. Это на самом деле правда. Подождите секундочку, я же говорил, что компьютеры меня ненавидят!

Один слайд потерялся, но это действительно самый юг СССР, где я родился в республике, которая была расположена прямо по соседству с Республикой Джорджия (прим. переводчика: название штата Джорджия и республики Грузия по-английски звучит одинаково).

Если говорить о моей родине, забавно то, что моя последняя книга «Deep Thinking» была написана об искусственном интеллекте, о моем собственном опыте сражений с компьютерами, а книга, написанная за два года перед этим, называлась «Зима приближается». Это не было синопсисом «Игры тронов», речь шла о Владимире Путине и борьбе за свободный мир, но когда я проводил тур презентации этой книги, все хотели спросить меня о шахматах и компьютере IBM Deep Blue. Сейчас, когда я презентую книгу «Deep Thinking», все хотят спросить меня о Путине. Но я стараюсь придерживаться темы, и я уверен, что после этой презентации будут несколько вопросов, на которые я буду рад ответить. Я не политик, поэтому не уклоняюсь от ответов на вопросы.

Может показаться странным, что игра в шахматы, возникшая тысячи лет назад, Бог знает когда, является идеальной аналогией искусственного интеллекта, потому что когда мы говорим об AI, мы должны помнить, что буква I означает «интеллект», и нет ничего, что демонстрирует это лучше, чем шахматы.

Многие люди считают, что шахматы не более чем забава, которой предаются люди в кафе. Если посмотреть на творения Голливуда, то все играют в шахматы – инопланетяне, люди Х, Визард, вампиры. Моя любимая картина «Касабланка» с Хэмфри Богартом тоже про шахматы, и когда я пересматриваю этот фильм, мне всегда хочется встать в такую позицию, чтобы заглянуть внутрь экрана и увидеть, доску Богарта. Он играет французскую защиту, которая была очень популярна в начале 40-х годов. Я думаю, Богарт был довольно приличным шахматистом.

Хочу упомянуть, что Альфред Бине, один из соавторов IQ-теста конца 19 века, восхищался умом шахматистов и изучал его на протяжении многих лет. Поэтому не удивительно, что игра в шахматы привлекает тех, кто хотел создавать умные машины. Однако часто бывает так, что интеллектуальные машины, такие, как «Турок» фон Кемпелена, являются просто грандиозным надувательством. Но в конце 18 века этот шахматный автомат был большим чудом, он гастролировал по Европе и Америке и сражался с сильными и слабыми игроками, такими, как Франклин и Наполеон, но конечно, всё это был обман. «Турок» не был настоящей машиной, это была оригинальная механическая система из скользящих панелей и зеркал, внутри которой прятался сильный игрок – человек.

Интересно то, что спустя сто или двести лет, в течение последнего двадцатилетия, наблюдается противоположная ситуация – мы наблюдаем на турнирах, что игроки-люди пытаются спрятать компьютерные девайсы в своих карманах. Так что теперь нам приходится искать компьютер, спрятанный в людском теле.

Однако истории с механическими устройствами сравнительно малоизвестны. Первое механической устройство для игры в шахматы появилось в 1912 году, оно играло при помощи одной механической части, могло сделать мат ладьей, но его нельзя было назвать прототипом первого компьютера.

Интересно то, что создали основ компьютерного дизайна, такие как Алан Тьюринг и Клод Шеннон, проявляли большой интерес к шахматам. Они верили, что игра в шахматы может раскрыть секреты искусственного интеллекта. И если однажды компьютер победит обычного шахматиста или чемпиона мира по шахматам, это будет проявлением эволюции ИИ.

Если помните, Алан Тьюринг в 1952 году создал первую компьютерную программу для игры в шахматы, и это было великим достижением, но ещё более значимым было то, что тогда ещё не было никаких компьютеров. Это был просто алгоритм, который он использовал, чтобы играть в шахматы, и он действовал как человеческий компьютерный процессор. Важно помнить, что отцы-основатели компьютеров определили путь, по которому должен был развиваться ИИ, следуя процессам человеческого мышления. Противоположным путем является то, что мы называем атакой brute-force, или быстрым перебором возможных вариантов ходов.

Я ничего не слышал о соревнованиях с компьютерами в 1985 году, но на этой фотографии вы можете увидеть 32 доски, и хотя я играл с людьми, но на самом деле это была реальная игра против компьютеров. На то время было 4 ведущих производителя шахматных компьютеров, которые как раз представили их миру. Возможно, у кого-то из вас ещё сохранились такие компьютеры, сейчас это настоящие раритеты. У каждого производителя было по 8 компьютерных модулей, так что реально я играл с 32 противниками и выиграл все партии.

Очень важно то, что это было не сюрпризом, а естественным результатом, и каждый раз, когда я смотрю на эту фотографию, где запечатлена моя победа, то вспоминаю об этом времени как о золотом веке шахматных машин, когда они были слабыми, а мои волосы – густыми.

Итак, это был июнь 1985 года, а спустя 12 лет я сыграл против всего лишь одного компьютера. В 1997 году был матч-реванш, потому что я выиграл первый матч, который состоялся в 1996 году в Филадельфии. Я проиграл этот матч-реванш, но отмечу ради справедливости, переломный момент в компьютерных шахматах состоялся не в 1997, а в 1996 году, когда я выиграл матч, но проиграл первую партию. Затем я выиграл 3 партии, и счёт стал 4:2 в мою пользу.

На самом деле, здесь важен факт, что компьютер в то время был способен стать чемпионом мира по шахматам, если бы играл в обычном шахматном турнире. Я не ожидал от IBM, что они смогут за год проделать такую серьезную техническую работу по усилению своего компьютера. Но самой большой моей ошибкой, за исключением резкого повышения курса акций IBM, которые через 2 недели после матча подскочили с нескольких пунктов до миллиарда долларов, была невозможность прочитать мелкий шрифт. Потому что одной из проблем 1996 года, с которой я столкнулся, играя с компьютером Deep Blue, было то, что для меня он являлся «черным ящиком». Я ничего не знал о сопернике, о том, как он думает, какую тактику использует. Обычно, когда ты готовишься к игре, то изучаешь противника, неважно, будет ли это шахматный матч или футбольный, и, наблюдая за манерой игры, изучаешь его стратегию. Но в отношении «манеры игры» Deep Blue не было никакой информации.

Я постарался быть умнее и заявил, что к следующему матчу у меня должен быть доступ к играм, сыгранным Deep Blue. Они ответили: «Конечно!», но при этом добавили мелким шрифтом:

«…только во время официальных соревнований».

И это при том, что Deep Blue не сыграл ни одной игры вне лабораторных стен. Так что в 1997 я играл против «черного ящика», и всё получилось противоположно событиям 1996 года – я выиграл первую партию, но проиграл матч.

К слову, где были вы, хакеры, 20 лет назад, когда так были мне нужны? Правда, когда я пробегаю взглядом по рядам присутствующих, то понимаю, что многие из вас, наверное, тогда ещё не родились.

Самой большой моей ошибкой было то, что я воспринимал матч с Deep Blue как великий научный и социальный эксперимент. Я думал, что он будет великим, потому что действительно найдёт ту область, где человеческую интуицию можно сравнить с «грубой силой» компьютерных вычислений. Однако Deep Blue со своей феноменальной скоростью вычислений порядка 2 миллионов шахматных позиций в секунду, что было совсем неплохо для 1997 года, был чем угодно, но только не искусственным интеллектом. Его игра не внесла никакого вклада в раскрытие тайны человеческого интеллекта.

Он был разумен не более, чем обычный будильник, однако мне не легче от того, что я проиграл будильнику стоимостью 10 миллионов долларов.

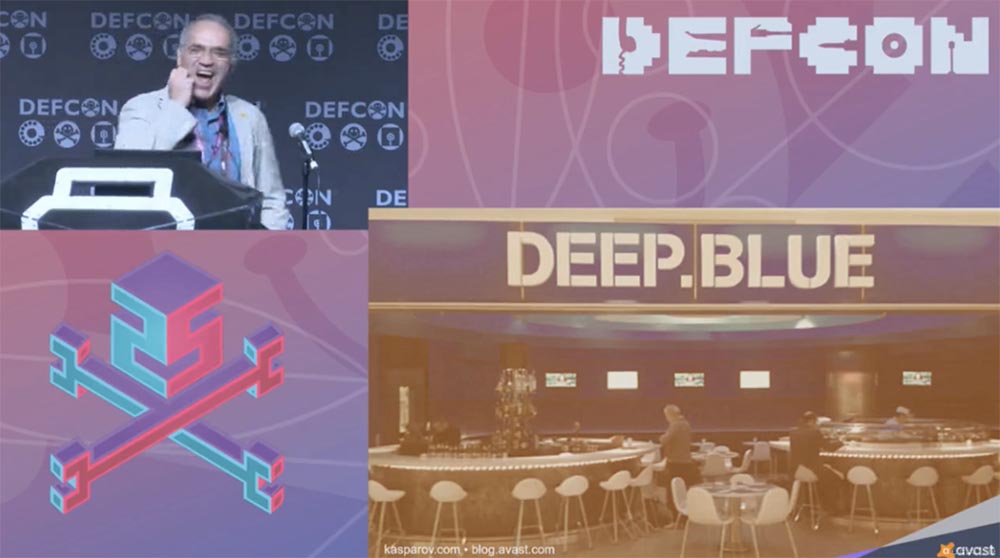

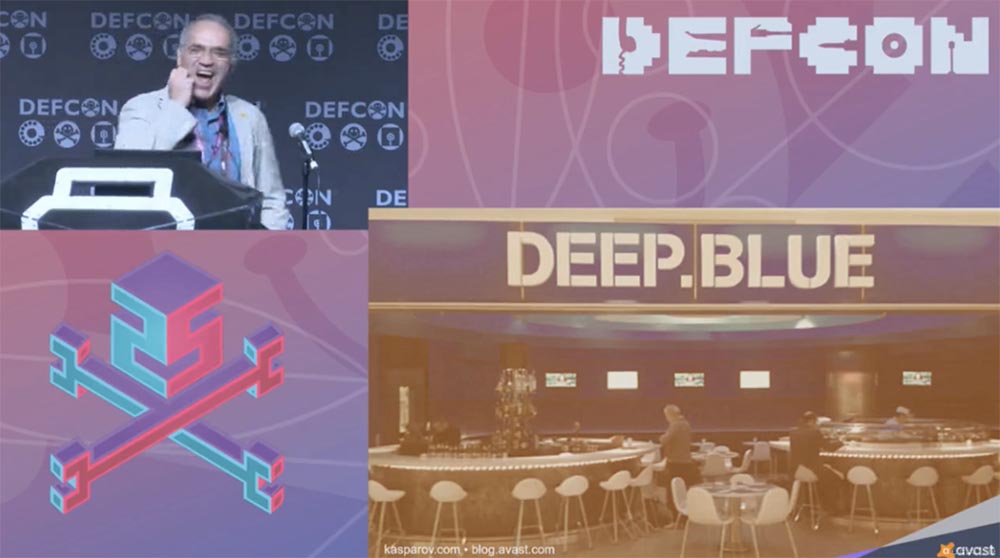

Я помню пресс-конференцию во время церемонии открытия матча, когда человек, возглавлявший проект IBM, сказал, что это ознаменует конец научных опытов и победу науки. Поскольку у нас была одна победа и один проигрыш, я хотел сыграть третий матч, чтобы выяснить, кто же все-таки сильнее, но они разобрали компьютер, видимо, чтобы убрать единственного беспристрастного свидетеля. Я пытался выяснить, что случилось с Deep Blue, но не смог это узнать. Позже я узнал, что он сделал новую карьеру и теперь готовит суши в одном из терминалов аэропорта имени Кеннеди.

Я люблю суши, но компьютер мне там не нужен. Итак, на этом моя история с компьютерными шахматами довольно быстро закончилась. Но те из вас, кто тоже играет в шахматы или другие игры, знают, насколько мы уязвимы по сравнению с компьютерами, потому что мы не настолько стабильны, беспристрастны и совершаем ошибки. Даже игроки высочайшего уровня делают ошибки, например, во время матча на звание чемпиона, где делается 50 или 45 ходов, неизбежна хотя бы одна крохотная ошибка. Если играют живые люди, она не имеет особого значения, но если вы делаете ошибку при игре с машиной, то возможно, что вы не проиграете, но и не выиграете, потому что машина сумеет избежать поражения.

В какой-то момент я понял, что это просто вопрос времени, потому что мы не можем достигнуть такого же уровня бдительности и точности, которая необходима для победы над компьютером, потому что машина необычайно стабильна в своих поступках. Годы спустя мы стали свидетелями того, что машины постоянно выигрывали матчи. Ещё раз повторюсь – это всё касается всего лишь игры в шахматы, которая очень уязвима к методу игры brute-forсe, когда компьютер с огромной скоростью перебирает множество вариантов ходов и выбирает самый оптимальный. Это не искусственный интеллект, поэтому люди совершают ошибку, когда говорят, что человек — шахматист был побежден искусственным интеллектом.

Позже я сыграл еще несколько матчей против компьютеров. Однажды я проанализировал эти игры, используя современные шахматные движки, и это был довольно болезненный опыт. Это было путешествие в прошлое, и я был вынужден признать, насколько слабо провел эти матчи, потому что мог пенять только на самого себя. Однако в то время компьютерный «демон» не был настолько силён, вы можете не верить, но бесплатное шахматное приложение на вашем мобильном устройстве на сегодня сильнее, чем был Deep Blue. Конечно, если у вас есть шахматный движок типа asmFish или Comodo и новейший ноутбук, эта система будет еще мощнее.

Когда я играл против Deep Blue, думаю, это была 5 игра, компьютер в эндшпиле поставил вечный шах, и все стали говорить, что это великая победа и что компьютер показал феноменальное качество игры. Но сегодня, с современным компьютером, это выглядит просто смешным. Весь наш матч можно сыграть за 30 секунд, максимум минуту в зависимости от производительности вашего ноутбука. В начале я сделал ошибку, потом попытался спасти игру, Deep Blue сделал несколько ответных ходов и выиграл. Таковы правила игры, и в этом нет ничего плохого.

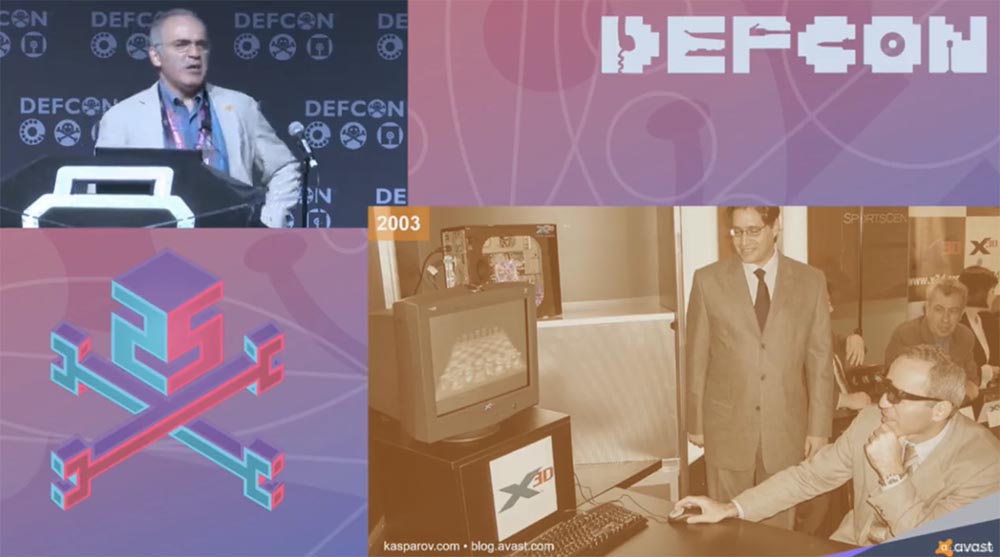

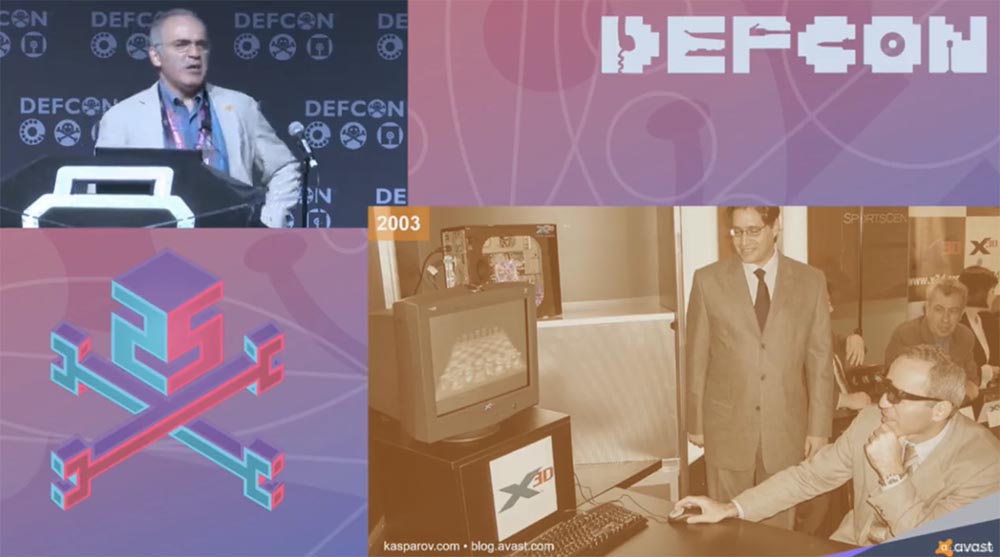

В 2003 году я сыграл ещё 2 матча против компьютера X3D Frintz, они оба закончились вничью. Организаторы заставили меня надеть 3-D очки, потому что компьютер имел 3-х мерный интерфейс.

Но в любом случае, история была закончена и я думал о будущем. Посмотрите на эту фотографию, которая была сделана в начале этого века.

Если посмотреть на этих детей, видно, что они играют на раритетных компьютерах. Сегодня мои дети даже не поймут, что это такое. Здесь изображены какие-то сложные клавиатуры, а сейчас они просто скользят пальцами по тачскрину.

Важно то, что более интеллектуальные машины делают наши задачи намного легче. Вероятно, я зря говорю это, потому что вы это знаете лучше, чем кто-либо другой. Таким образом, с помощью Свинки Пеппы и технических задач расчищается путь для подлинного творчества.

Я задумался о том, как же можно соединить силу компьютера и человека? В качестве примера можно взять шахматы, потому что в шахматах имеется решение. Вы прекрасно знаете, в каких областях компьютер силен, а в каких уступает человеку. И тогда мне на ум пришла концепция, которую я назвал «продвинутые шахматы».

Следуя русской поговорке: «если не можешь победить – присоединяйся!», я назвал продвинутыми шахматами игру, когда один человек с компьютером сражается против другого человека с компьютером.

В 1998 году я играл с представителем шахматной элиты из Болгарии, и самое интересное то, что мы оба не смогли хорошо сыграть, потому что не смогли максимизировать эффект от совместной работы с компьютером. Я задался вопросом, почему два великих игрока не смогли извлечь пользу от сотрудничества с ИИ. Ответ пришел позже с введением так называемого фристайла с ограничением количества подсказок со стороны компьютера. Вы можете играть, подключившись к суперкомпьютеру через интернет, можете использовать собственный компьютер или много компьютеров. Я хочу заметить, что пара «человек-компьютер» всегда превзойдет любой суперкомпьютер. Причина очень проста – компьютер компенсирует нашу рассеянность, и мы оказываемся в хорошем положении, переключаясь на компьютер, потому что это исключает уязвимость, когда другой компьютер может воспользоваться нашей человеческой слабостью.

Но в этом нет ничего сенсационного. Сенсацией стало то, что победителями соревнования стали не игроки высшего класса, а относительно слабые шахматисты с обычными компьютерами, но зато сумевшие создать улучшенный процесс взаимодействия. Это трудно сформулировать, потому что оно звучит парадоксально: слабый игрок плюс обычный компьютер плюс улучшенный процесс превосходят сильного игрока с мощным компьютером, но слабым процессом взаимодействия. Интерфейс решает всё!

Интересно то, что вам совсем не нужен сильный игрок, не нужен Гарри Каспаров, для того, чтобы находясь на стороне машины, найти наилучший ход, и на это есть простой ответ. Если сегодня рассматривать относительно сильные стороны человека и компьютера, можно выйти за пределы шахмат, но давайте начнем все-таки с них, потому что в шахматах имеются числа. Итак, мой рекордный шахматный рейтинг составлял 2851 балл, пока я не проиграл Магнусу Карлсену, и в момент завершения моей шахматной карьеры он составлял 2812 баллов. На сегодня Магнус Карлсен возглавляет рейтинг выше 2800 баллов. Примерно 50 игроков имеют рейтинг между отметками 2700 и 2800 баллов. Это элита шахматного мира. В наши дни мощь компьютера находится в пределах 3200 баллов, а с учетом специализированного программного обеспечения его рейтинг может достичь 3300-3400 баллов.

Теперь вы поняли, почему вам не нужен сильный игрок? Потому что игрок моего уровня будет стараться подтолкнуть компьютер действовать в том или ином направлении, вместо того, чтобы быть при нем простым оператором. Поэтому более слабый шахматист, который не имеет такого «гонора» и такого самомнения, как чемпион мира по шахматам, будет взаимодействовать с компьютером намного эффективнее и образует более продуктивную комбинацию «человек-компьютер».

Я думаю, что это очень важное открытие не только для шахмат, но и, например, для медицины. Как известно, компьютеры во многих случаях способны поставить более точный диагноз, чем это делают лучшие врачи. Так чего бы вы больше хотели: хорошего доктора в лице компьютера или хорошую медсестру, которая будет просто следовать инструкциям и составлять небольшое руководство на основании рекомендаций машины?

Я не знаю точные цифры, предположим, 60-65% людей выберут доктора, а 85% будут за компьютер, но психологически, если вы хороший доктор, вы не сможете это принять. Если посмотреть на сегодняшний технический прогресс, то можно сказать, что компьютеры ставят правдивый диагноз в 80 – 85 — 90 % случаев, но 10% все равно остаются людям! А это может представлять собой огромную разницу, ведь когда при выстреле пуля отклоняется всего на 1 градус, то она может пролететь на расстоянии нескольких сотен метров от мишени. Вопрос касается того, способны ли мы направить в нужное русло всю мощь компьютерных вычислений.

Поэтому я до сих пор верю, что все страхи по поводу того, что машины вскоре заменят всех нас, и это станет концом света, Армагеддоном — всего лишь слухи. Потому что, как я сказал, это касается творческих способностей человека, и уникальность компьютерного интеллекта состоит в том, что он всего лишь усиливает наши творческие способности, высвобождает их и подсказывает, как использовать их наилучшим образом.

Иногда, чтобы найти ответ на вопрос, стоит отойти от мира науки и углубиться в мир искусства. Как-то я нашел отличный парадокс, изложенный великим художником Пабло Пикассо: «Компьютеры бесполезны. Единственное, что они могут – это давать ответы». Я думаю, что в этом заключается великая мудрость и эти слова звучат обнадеживающе, потому что машины все же дают ответы, и эти ответы исчерпывающие!

Однако Пикассо не удовлетворяли исчерпывающие ответы, потому что он был художником. Это связанно с постоянным переосмыслением искусства, это именно то, что мы постоянно делаем – задаем вопросы. А могут ли компьютеры задавать вопросы?

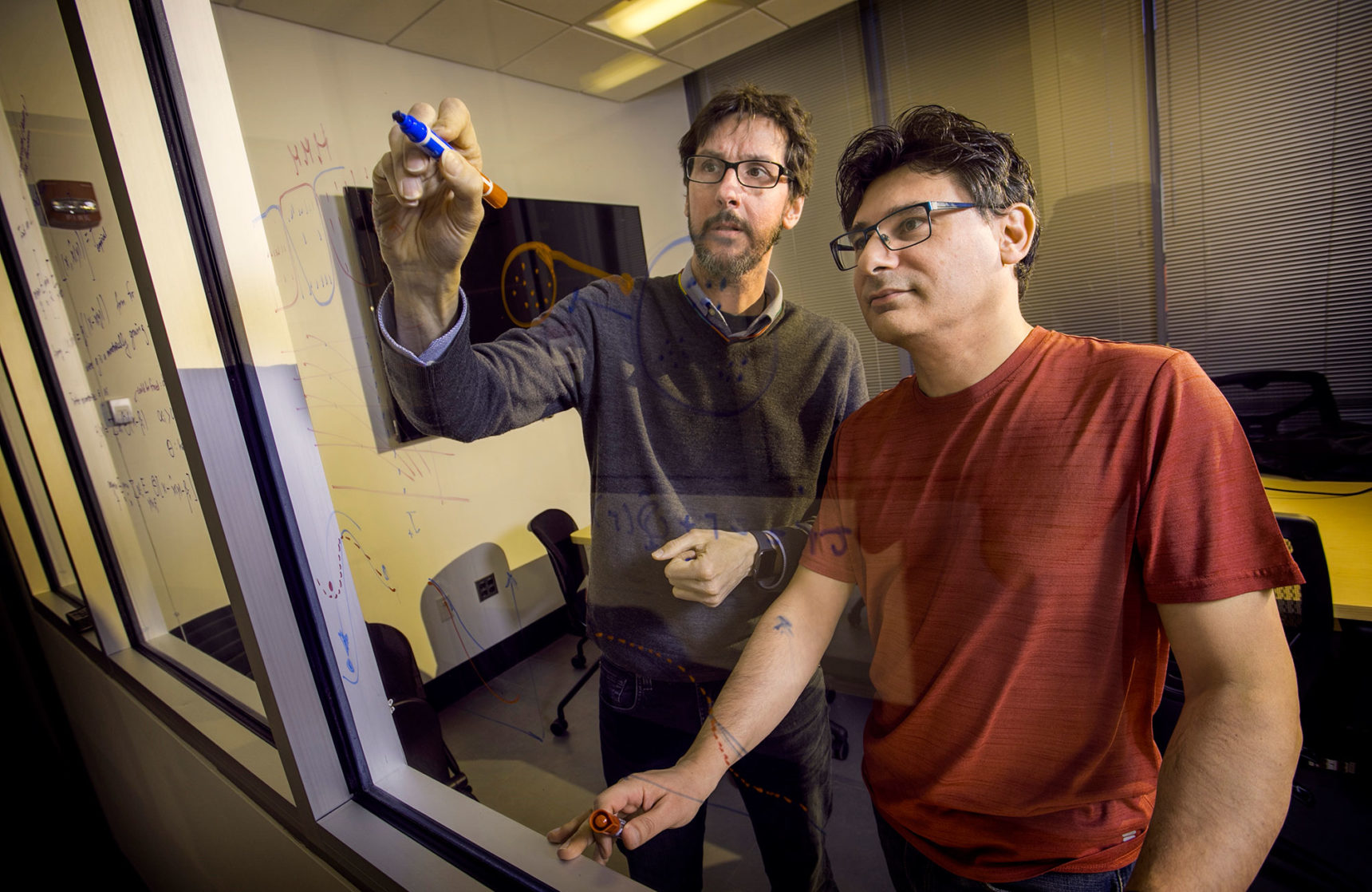

Однажды я посетил хеджевый фонд Bridgewater Associates, где собирался поговорить с Дейвом Феруччи, одним из разработчиков суперкомпьютера Watson IBM. Мы говорили о том, могут ли машины задавать вопросы, и Дэйв сказал: «Да, компьютеры могут задавать вопросы, но они не знают, какие из вопросов действительно имеют значение». Вот в чем заключается суть. Таким образом, мы всё еще в игре и у нас есть шанс двигаться дальше, потому что игра человека и компьютера еще не закончена.

На этом слайде вы видите несколько фотографий возможных областей использования автономных компьютеров, машин, которые могут программировать сами себя, то есть обладают способностями к обучению.

На одной из фотографий изображен Демис Хассабис со своей самообучающейся нейронной сетью AlphaGo. На самом деле это, вероятно, первая машина, которую можно назвать прототипом искусственного интеллекта.

Как я уже сказал, Deep Blue – это перебор brute-force, Watson – возможно, переходное звено, но не ещё не ИИ. AlphaGo — это программа глубинного обучения, которая самосовершенствуется, находя соответствующие модели, играя в миллионы и миллионы игр.

Я могу сказать, что в случае AlphaGo мы впервые имеем дело с настоящим «черным ящиком». Потому что, например, если мы потратим сотню лет на изучение тысячи миль игровых логов Deep Blue, то в конце концов доберемся до оригинальной идеи, почему было принято именно это решение и сделан именно этот ход. Что же касается AlphaGo, я уверен, что даже сам Демис Хассабис не сможет сказать, чем версия 6 лучше версии 9, или наоборот, имея в виду решение, принятое этой машиной.

С одной стороны, это большое достижение, а с другой стороны это может быть проблемой, потому что если машина сделала ошибку, вы не сможете об этом узнать. Однако в любом случае это движение в сторону создания настоящего ИИ.

Как-то я выступал в штаб-квартире Google, и они организовали мне экскурсию по Google X. Эта было очень интересно, потому что данная компания уверенно движется в направлении создания ИИ, решая проблемы создания самоуправляемого автомобиля или автономных дронов, самостоятельно доставляющих грузы. Однако не меньшей проблемой, чем техническое обеспечение ИИ, является проблема регулирования его деятельности. Люди говорят о том, что ИИ может полностью заменить их, лишив работы. Однако давайте призовем на помощь историю человеческой цивилизации – подобное происходило сотни и тысячи лет!

24:35 мин

https://www.youtube.com/watch?v=fp7Pq7_tHsY

Конференция DEFCON 25. Гарри Каспаров. «Последняя битва мозга». Часть 2

Спасибо, что остаётесь с нами. Вам нравятся наши статьи? Хотите видеть больше интересных материалов? Поддержите нас оформив заказ или порекомендовав знакомым, 30% скидка для пользователей Хабра на уникальный аналог entry-level серверов, который был придуман нами для Вас: Вся правда о VPS (KVM) E5-2650 v4 (6 Cores) 10GB DDR4 240GB SSD 1Gbps от $20 или как правильно делить сервер? (доступны варианты с RAID1 и RAID10, до 24 ядер и до 40GB DDR4).

Dell R730xd в 2 раза дешевле? Только у нас 2 х Intel TetraDeca-Core Xeon 2x E5-2697v3 2.6GHz 14C 64GB DDR4 4x960GB SSD 1Gbps 100 ТВ от $199 в Нидерландах! Dell R420 — 2x E5-2430 2.2Ghz 6C 128GB DDR3 2x960GB SSD 1Gbps 100TB — от $99! Читайте о том Как построить инфраструктуру корп. класса c применением серверов Dell R730xd Е5-2650 v4 стоимостью 9000 евро за копейки?

Let's block ads! (Why?)