Хочу продолжить свое повествование о сборке «деревенского суперкомпьютера». И поясню почему он так назван — причина простая. Я сам живу в деревне. И название — легкий троллинг над теми кто кричит в интернете «За МКАД жизни нет!», «Русская деревня спилась и вымирает!» Так вот, где-то это может быть и так, а я буду исключением из правил. Не пью, не курю, делаю вещи которые не всякому «городскому креаклу(с)» по уму и карману. Но вернемся к нашим баранам, точнее — серверу, который в конце первой части статьи уже «подавал признаки жизни».

Плата лежала на столе, я полазил по BIOS настраивая его по своему вкусу, накатал Ubuntu 16.04 Desktop для простоты и решил подключить к «супер-машине» видеокарту. Но под рукой была только GTS 250 с приклеенным здоровенным не родным вентилятором. Которую я и установил в PCI-E 16x слот около кнопки питания.

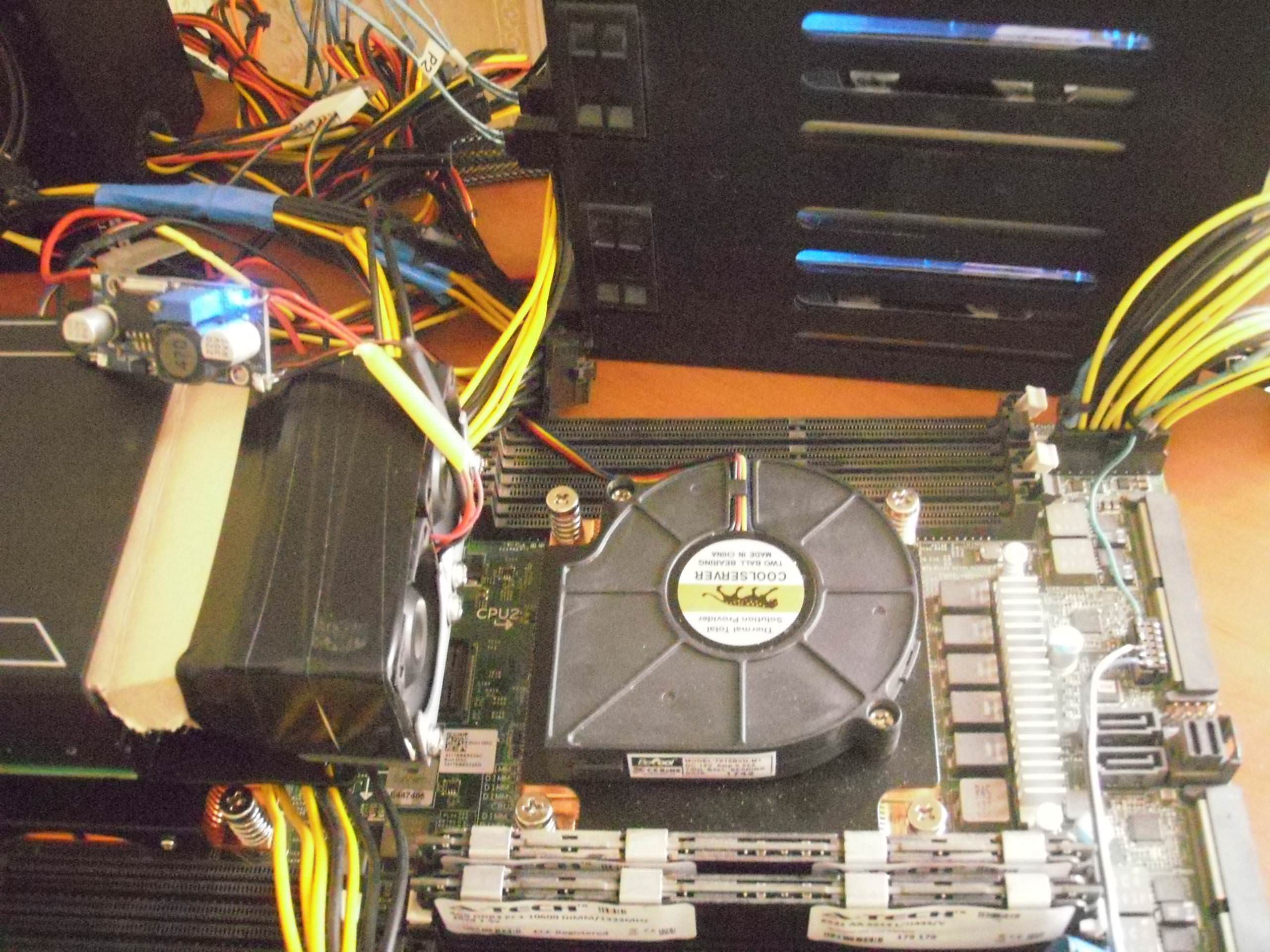

«Снимал на пачку Беломора(с)» так что прошу не пинать за качество фото. Лучше я прокомментирую то, что на них запечатлено.

Во первых — оказалось что при установке в слот — даже коротая видеокарта упирается платой в разъемы памяти, в которые по этому случаю ее нельзя установить и даже приходится опускать защелки. Во вторых железная крепежная планка видеокарты закрывает кнопку питания, так что ее пришлось снять. Кстати и сама кнопка питания — подсвечена двухцветным светодиодом, который горит зеленым когда все в порядке и мигает оранжевым если какие-то проблемы, замыкание и сработала защита БП или питание +12VSB завышено или занижено.

На самом деле, эта материнская плата не предназначена чтобы в ее слоты PCI-E 16x включались видеокарты «напрямую», они все присоединяются на райзерах. Для установки карты расширения в слоты около кнопки питания есть угловые райзеры, низкий для установки коротких карт длиной до первого радиатора процессора, и высокий угловой с разъемом дополнительного питания +12В для установки видеокарты «над» штатным низким 1U кулером. В него можно включать большие видеокарты вроде GTX 780, GTX 980, GTX 1080 либо специализированные GPGPU-карты Nvidia Tesla K10-K20-K40 или «вычислительные карты» Intel Xeon Phi 5110p и ему подобные.

Зато в GPGPU-райзер включаемый в EdgeSlot карту можно включить напрямую, только опять же подключив дополнительное питание таким-же разъемом как на высоком угловом райзере. Кому интересно — на eBay этот гибкий райзер называется «Dell PowerEdge C8220X PCI-E GPGPU DJC89» и стоит около 2.5-3 тысяч рублей. А вот угловые райзеры с дополнительным питанием штука намного более редкая и мне пришлось договариваться чтобы их купили из специализированного магазина серверных запчастей через Шопотам. Вышли они по 7 тысяч за штуку.

Скажу сразу, «рисковые парни(тм)» могут подключить даже пару GTX 980 к плате китайскими гибкими райзерами 16х как сделал один человек на «Том Самом Форуме», они кстати делают вполне неплохо работающие на PCI-E 16х 2.0 поделки в стиле Термалтэковских гибких райзеров, но если у вас от такого однажды прогорят цепи питания на плате сервера — винить будете только себя. Я не стал рисковать дорогим оборудованием и использовал оригинальные райзеры с дополнительным питанием и один китайский гибкий, посчитав что подключение одной карты «напрямую» плату не спалит.

Потом приехали долгожданные разъемы для подключения дополнительного питания и я сделал хвост для своего райзера в EdgeSlot и такой-хже разъем но с иной распиновкой использовал чтобы подать дополнительное питание и на материнскую плату. Он как раз около этого самого разъема EdgeSlot, там интересная раписновка. Если на райзере 2 провода +12 и 2 общих, то на плате 3 провода +12 и 1 общий.

Вот собственно та самая GTS 250 включена в GPGPU-райзер. Дополнительное питание у меня кстати берется на райзеры и материнку — со второго разъема питания CPU моего БП. Я решил что так будет сделать более правильно.

Быстро сказка сказывается, да медленно посылки в Россию из Китая и других мест земного шара едут. Потому в сборке «суперкомпьютера» были большие промежутки. Но вот наконец ко мне приехала серверная Nvidia Tesla K20M с пассивным радиатором. Причем совершенно нулевая, с хранения, заклеенная в родную коробку, в родной пакет, с гарантийными бумажками. И начались страдания как же ее охлаждать?

Сначала был куплен из Англии кастомный кулер с двумя маленькими «турбинами», вот оно на фото, с самодельным картонным диффузором.

И оказались они полной лажей. Шумели сильно, крепление не подошло вообще, дули слабо и давали такую вибрацию что я боялся что от платы Теслы компоненты отвалятся! Почему они были отправлены в помойку почти сразу.

Кстати, на фото под Теслой видны установленные на процессоры радиаторы LGA 2011 1U серверные медные с улиткой от Coolerserver купленные с Алиэкспресса. Весьма достойные хотя и шумноватые кулеры. Подошли идеально.

Но собственно пока я ждал новый кулер на Теслу, на этот раз заказав аж из Австралии улитку большую с распечатанным на 3D-принтере креплением, дошло дело до системы хранения данных сервера. На плате сервера есть разъем mini-SAS через который выведены 4 SATA и еще 2 SATA обычными разъемами. На еВау я купил кабель mini-SAS to 4 SATA длиной в метр, а на Авито — корзину горячей замены в 5,25" отсек на 4 2,5" IDE SAS-SATA. Так что когда приехал кабель и корзина — в нее были установлены 4 теребайтных Сигейта, в BIOS был собран RAID5 на 4 устройства, начал я ставить серверную Ubuntu… и уткнулся в то что программа разметки дисков не давала на рейде сделать swap-раздел.

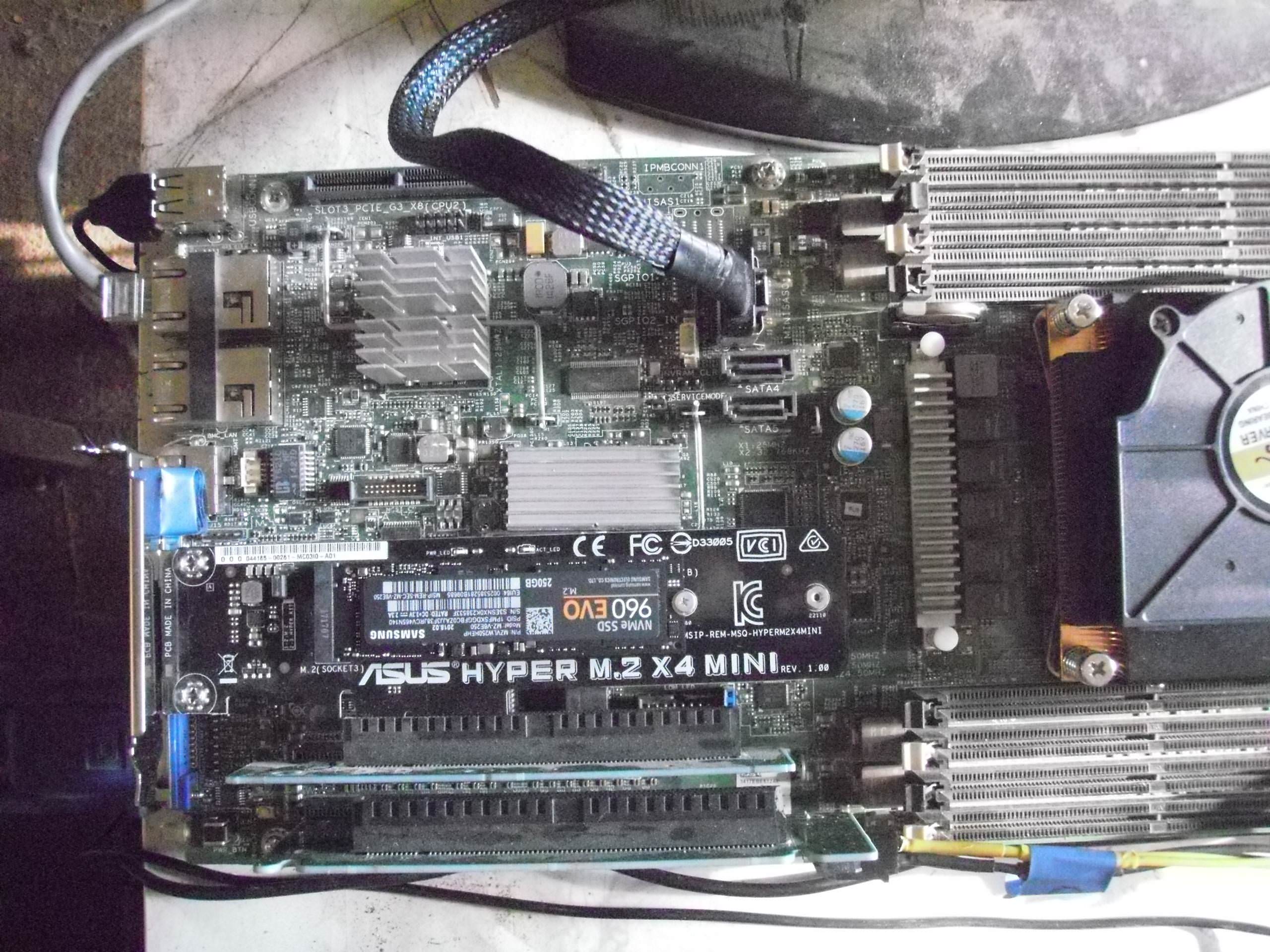

Решил я проблему в лоб — купил в DNS PCI-E to M.2 адаптер ASUS HYPER M.2 x 4 MINI и M.2 SSD Samsung EVO 250 Gb реши что под swap надо выделить максимально скоростное устройство, раз система будет работать с высокой вычислительной нагрузкой а памяти все равно заведомо меньше чем размер данных. Да и память на 256 гб дороже была чем этот SSD.

Вот этот самый переходник с установленным SSD в низ ком угловом райзере.

Предвидя вопросы — «А почему не сделать всю систему на М.2 и иметь максимальную скорость доступа выше чем у рейда на SATA?» — отвечу. Во первых на 1 и более Тб М2 SSD стоят для меня слишком по конский. Во вторых — даже после обновления BIOS на последнюю версию 2.8.1 сервер все равно не поддерживает загрузку в M.2 NVE устройств. Я делал опыт когда система ставила /boot на USB FLASH 64 Gb а все остальное на М2, но мне не понравилось. Хотя в принципе такая связка вполне работоспособна. Если М2 большой емкости подешевеют — я возможно вернусь к такому варианту, но пока SATA RAID как система хранения меня вполне устраивает.

Когда с дисковой подсистемой я определился придя к комбинации 2 х SSD RAID1 / + 4 x HDD RAID5 + M.2 SSD swap пришло время продолжить свои опыты с GPU. Тесла у меня уже была и как раз приехал австралийский кулер со «злой» улиткой кушающей аж 2.94А по 12В, второй слот занимала М2 и для третьего я одолжил «на опыты» GT 610.

Вот на фото все 3 устройства подключены, причем М2 SSD через гибкий Термалтэковский райзер для видеокарт который на 3.0 шине работает без ошибок. Он вот такиих, из множества отдельных «ленточек» на подобии тех из которых сделаны кабели SATA. PCI-E 16x райзеры сделанные из монллитного плоского шлейфа вроде как у старых IDE — в топку, они замучают ошибками из-за наводок взаимных. И как я уже говорил китайцы делают теперь тоже такие райзеры как у Термалтэка но короче.

В кокмбинации с Теслой К20 + GT 610 я много чего пробовал, заодно выяснив что при подключении внешней видеокарты и преключении на нее вывода в BIOS не работает vKVM, что меня не особо расстроило. Все равно использовать на этой системе внешнее видео я не планировал, на Теслах нет видеовыходов, а удаленная админка по SSH и без Х-сов работает прекрасно. Зато IPMI + vKVM очень упрощает управление, переустановку и прочие моменты с удаленным сервером.

Вообще у этой платы IPMI шикарен. Отдельный порт 100 мбит, возможность перенастроить инжекцию пакетов на один их 10 Гбит портов, Web-сервер встроенный для управления питанием и контроля серверов, закачка прямо из него Java-клиента vKVM и клиента удаленного монтирования дисков или образов для переустановки… Единственное — клиенты под старую Java Оракловскую, которая уже не поддерживается в Linux и для удаленной админки пришлось завести ноутбук с Win XP SP3 с этой самой древней Жабой. Ну и клиент медленный, для админки и всего такого хватает, но в игрушки не поиграешь удаленно, FPS маленький. Да и видео ASPEED которое интегрировано с IPMI слабенькое только VGA.

В процессе разбирательства с сервером я многое узнал и многому научился в области профессионального серверного железа фирмы Dell. О чем совсем не жалею, как и о потраченно с пользой времени и деньгах. Продолжение познавательной истории про собственно сборку каркаса со всеми компонетами сервера будет позднее.

...

воскресенье, 2 июня 2019 г.

История сборки «деревенского суперкомпьютера» из запчастей с eBay, Aliexpress и компьютерного магазина. Часть 2

Доброго времени суток, дорогие Хабровчане!

Подписаться на:

Комментарии к сообщению (Atom)

Комментариев нет:

Отправить комментарий